3.2.2

参考指南

本指南描述了 Spring Cloud Stream Binder 的 Apache Kafka 实现。它包含了关于其设计、用法和配置选项的信息,以及 Stream Cloud Stream 概念如何映射到 Apache Kafka 特定构造的信息。此外,本指南还解释了 Spring Cloud Stream 的 Kafka Streams 绑定功能。

1. Apache Kafka Binder

1.1. 用法

要使用 Apache Kafka binder,您需要将 spring-cloud-stream-binder-kafka 添加为 Spring Cloud Stream 应用程序的依赖项,如下面的 Maven 示例所示

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-stream-binder-kafka</artifactId>

</dependency>或者,您也可以使用 Spring Cloud Stream Kafka Starter,如下面的 Maven 示例所示

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-stream-kafka</artifactId>

</dependency>1.2. 概览

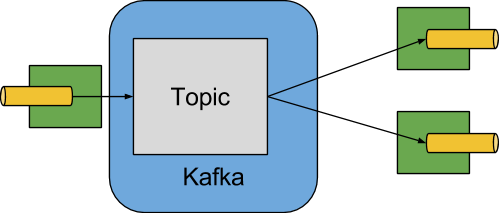

下图显示了 Apache Kafka binder 操作的简化图

Apache Kafka Binder 实现将每个目标映射到 Apache Kafka 主题。消费者组直接映射到相同的 Apache Kafka 概念。分区也直接映射到 Apache Kafka 分区。

binder 当前使用 Apache Kafka kafka-clients 版本 2.3.1。此客户端可以与旧代理通信(请参阅 Kafka 文档),但某些功能可能不可用。例如,对于早于 0.11.x.x 的版本,不支持原生头。此外,0.11.x.x 不支持 autoAddPartitions 属性。

1.3. 配置选项

本节包含 Apache Kafka binder 使用的配置选项。

有关 binder 的常见配置选项和属性,请参阅核心文档中的绑定属性。

1.3.1. Kafka Binder 属性

- spring.cloud.stream.kafka.binder.brokers

-

Kafka binder 连接的代理列表。

默认值:

localhost。 - spring.cloud.stream.kafka.binder.defaultBrokerPort

-

brokers允许指定带或不带端口信息的主机(例如,host1,host2:port2)。这设置了当代理列表中未配置端口时的默认端口。默认值:

9092。 - spring.cloud.stream.kafka.binder.configuration

-

键/值映射,包含传递给 binder 创建的所有客户端的客户端属性(生产者和消费者)。由于这些属性由生产者和消费者使用,因此用法应仅限于通用属性——例如,安全设置。通过此配置提供的未知 Kafka 生产者或消费者属性将被过滤掉,不允许传播。此处的属性将覆盖引导中设置的任何属性。

默认值:空映射。

- spring.cloud.stream.kafka.binder.consumerProperties

-

任意 Kafka 客户端消费者属性的键/值映射。除了支持已知的 Kafka 消费者属性外,此处也允许未知消费者属性。此处的属性将覆盖引导中设置的任何属性以及上面

configuration属性中设置的任何属性。默认值:空映射。

- spring.cloud.stream.kafka.binder.headers

-

由 binder 传输的自定义头列表。仅当与旧应用程序 (⇐ 1.3.x) 且

kafka-clients版本 < 0.11.0.0 通信时才需要。较新版本原生支持头。默认值:空。

- spring.cloud.stream.kafka.binder.healthTimeout

-

等待获取分区信息的时间,以秒为单位。如果此计时器到期,则健康报告为 down。

默认值:10。

- spring.cloud.stream.kafka.binder.requiredAcks

-

代理上所需的 ack 数量。有关生产者

acks属性,请参阅 Kafka 文档。默认值:

1。 - spring.cloud.stream.kafka.binder.minPartitionCount

-

仅当设置了

autoCreateTopics或autoAddPartitions时才有效。binder 在其生产或消费数据的主题上配置的全局最小分区数。它可以被生产者的partitionCount设置或生产者的instanceCount * concurrency设置的值(如果两者中任何一个更大)覆盖。默认值:

1。 - spring.cloud.stream.kafka.binder.producerProperties

-

任意 Kafka 客户端生产者属性的键/值映射。除了支持已知的 Kafka 生产者属性外,此处也允许未知生产者属性。此处的属性将覆盖引导中设置的任何属性以及上面

configuration属性中设置的任何属性。默认值:空映射。

- spring.cloud.stream.kafka.binder.replicationFactor

-

如果

autoCreateTopics处于活动状态,则自动创建主题的复制因子。可以在每个绑定上覆盖。如果您使用的 Kafka 代理版本早于 2.4,则此值应设置为至少 1。从 3.0.8 版本开始,binder 使用-1作为默认值,这表示将使用代理的“default.replication.factor”属性来确定副本数量。请咨询您的 Kafka 代理管理员,了解是否存在要求最小复制因子的策略,如果是这种情况,通常default.replication.factor将与该值匹配,并且应使用-1,除非您需要大于最小值的复制因子。默认值:

-1。 - spring.cloud.stream.kafka.binder.autoCreateTopics

-

如果设置为

true,则 binder 会自动创建新主题。如果设置为false,则 binder 依赖于已配置的主题。在后一种情况下,如果主题不存在,则 binder 无法启动。此设置独立于代理的 auto.create.topics.enable设置,并且不影响它。如果服务器设置为自动创建主题,则它们可能会作为元数据检索请求的一部分创建,并使用默认代理设置。默认值:

true。 - spring.cloud.stream.kafka.binder.autoAddPartitions

-

如果设置为

true,则 binder 会在需要时创建新分区。如果设置为false,则 binder 依赖于已配置的主题分区大小。如果目标主题的分区计数小于预期值,则 binder 无法启动。默认值:

false。 - spring.cloud.stream.kafka.binder.transaction.transactionIdPrefix

-

在 binder 中启用事务。有关 Kafka 文档中的

transaction.id和spring-kafka文档中的事务,请参阅相关内容。启用事务时,将忽略单个producer属性,并且所有生产者都使用spring.cloud.stream.kafka.binder.transaction.producer.*属性。默认

null(无事务) - spring.cloud.stream.kafka.binder.transaction.producer.*

-

事务性 binder 中生产者的全局生产者属性。请参阅

spring.cloud.stream.kafka.binder.transaction.transactionIdPrefix和Kafka 生产者属性以及所有 binder 支持的通用生产者属性。默认值:请参阅各个生产者属性。

- spring.cloud.stream.kafka.binder.headerMapperBeanName

-

用于将

spring-messaging头映射到 Kafka 头以及从 Kafka 头映射的KafkaHeaderMapper的 bean 名称。例如,如果您希望自定义使用 JSON 反序列化头的BinderHeaderMapperbean 中的受信任包,请使用此项。如果此自定义BinderHeaderMapperbean 未通过此属性提供给 binder,则 binder 将查找名称为kafkaBinderHeaderMapper且类型为BinderHeaderMapper的头映射器 bean,然后再回退到 binder 创建的默认BinderHeaderMapper。默认值:无。

- spring.cloud.stream.kafka.binder.considerDownWhenAnyPartitionHasNoLeader

-

当主题上的任何分区(无论从哪个消费者接收数据)被发现没有 leader 时,将 binder 健康状态设置为

down的标志。默认值:

false。 - spring.cloud.stream.kafka.binder.certificateStoreDirectory

-

当 truststore 或 keystore 证书位置以 classpath URL (

classpath:…) 给出时,binder 会将 JAR 文件内部 classpath 位置的资源复制到文件系统上的某个位置。这对于代理级别证书 (ssl.truststore.location和ssl.keystore.location) 和用于 schema 注册表 (schema.registry.ssl.truststore.location和schema.registry.ssl.keystore.location) 的证书都是如此。请记住,truststore 和 keystore 的 classpath 位置必须在spring.cloud.stream.kafka.binder.configuration…下提供。例如,spring.cloud.stream.kafka.binder.configuration.ssl.truststore.location、`spring.cloud.stream.kafka.binder.configuration.schema.registry.ssl.truststore.location等。文件将移动到此属性值指定的位置,该位置必须是文件系统上存在的目录,并且可由运行应用程序的进程写入。如果此值未设置且证书文件是 classpath 资源,则它将移动到由System.getProperty("java.io.tmpdir")返回的系统临时目录。如果此值存在但找不到目录或不可写入,则也是如此。默认值:无。

1.3.2. Kafka 消费者属性

为避免重复,Spring Cloud Stream 支持以 spring.cloud.stream.kafka.default.consumer.<property>=<value> 的格式为所有通道设置值。 |

以下属性仅适用于 Kafka 消费者,并且必须以 spring.cloud.stream.kafka.bindings.<channelName>.consumer. 为前缀。

- admin.configuration

-

自 2.1.1 版起,此属性已弃用,取而代之的是

topic.properties,并将在未来版本中移除对其的支持。 - admin.replicas-assignment

-

自 2.1.1 版起,此属性已弃用,取而代之的是

topic.replicas-assignment,并将在未来版本中移除对其的支持。 - admin.replication-factor

-

自 2.1.1 版起,此属性已弃用,取而代之的是

topic.replication-factor,并将在未来版本中移除对其的支持。 - autoRebalanceEnabled

-

当为

true时,主题分区会在消费者组的成员之间自动重新平衡。当为false时,每个消费者根据spring.cloud.stream.instanceCount和spring.cloud.stream.instanceIndex分配一组固定分区。这需要每个启动实例上都适当地设置spring.cloud.stream.instanceCount和spring.cloud.stream.instanceIndex属性。在这种情况下,spring.cloud.stream.instanceCount属性的值通常必须大于 1。默认值:

true。 - ackEachRecord

-

当

autoCommitOffset为true时,此设置决定是否在处理每个记录后提交偏移量。默认情况下,在处理完consumer.poll()返回的批次中的所有记录后,会提交偏移量。通过max.poll.recordsKafka 属性(通过消费者configuration属性设置)可以控制轮询返回的记录数。将其设置为true可能会导致性能下降,但这样做可以减少发生故障时重新投递记录的可能性。另请参阅 binder 的requiredAcks属性,它也会影响提交偏移量的性能。此属性自 3.1 版本起已弃用,取而代之的是使用ackMode。如果未设置ackMode且未启用批处理模式,将使用RECORDackMode。默认值:

false。 - autoCommitOffset

-

从 3.1 版本开始,此属性已弃用。有关替代方案的更多详细信息,请参阅

ackMode。消息处理后是否自动提交偏移量。如果设置为false,则入站消息中会存在一个键为kafka_acknowledgment且类型为org.springframework.kafka.support.Acknowledgment的头。应用程序可以使用此头来确认消息。有关详细信息,请参阅示例部分。当此属性设置为false时,Kafka binder 将确认模式设置为org.springframework.kafka.listener.AbstractMessageListenerContainer.AckMode.MANUAL,并且应用程序负责确认记录。另请参阅ackEachRecord。默认值:

true。 - ackMode

-

指定容器确认模式。这基于 Spring Kafka 中定义的 AckMode 枚举。如果

ackEachRecord属性设置为true且消费者不处于批处理模式,则将使用RECORD确认模式,否则,使用通过此属性提供的确认模式。 - autoCommitOnError

-

在可轮询消费者中,如果设置为

true,则总是在出错时自动提交。如果未设置(默认)或为 false,则在可轮询消费者中不会自动提交。请注意,此属性仅适用于可轮询消费者。默认值:未设置。

- resetOffsets

-

是否将消费者上的偏移量重置为 startOffset 提供的值。如果提供了

KafkaBindingRebalanceListener,则必须为 false;请参阅使用 KafkaBindingRebalanceListener。有关此属性的更多信息,请参阅重置偏移量。默认值:

false。 - startOffset

-

新组的起始偏移量。允许的值:

earliest和latest。如果为消费者“绑定”显式设置了消费者组(通过spring.cloud.stream.bindings.<channelName>.group),则“startOffset”设置为earliest。否则,对于anonymous消费者组,它设置为latest。有关此属性的更多信息,请参阅重置偏移量。默认值:null(等同于

earliest)。 - enableDlq

-

当设置为 true 时,它为消费者启用 DLQ 行为。默认情况下,导致错误的消息会转发到名为

error.<destination>.<group>的主题。DLQ 主题名称可以通过设置dlqName属性或定义类型为DlqDestinationResolver的@Bean来配置。这为更常见的 Kafka 重放场景提供了一种替代选项,适用于错误数量相对较少且重放整个原始主题可能过于繁琐的情况。有关更多信息,请参阅死信主题处理。从 2.0 版本开始,发送到 DLQ 主题的消息会添加以下头:x-original-topic、x-exception-message和x-exception-stacktrace作为byte[]。默认情况下,失败的记录会发送到 DLQ 主题中与原始记录相同分区号的分区。有关如何更改此行为,请参阅死信主题分区选择。当destinationIsPattern为true时不允许。默认值:

false。 - dlqPartitions

-

当

enableDlq为 true 且未设置此属性时,会创建一个死信主题,其分区数与主主题相同。通常,死信记录会发送到死信主题中与原始记录相同的分区。此行为可以更改;请参阅死信主题分区选择。如果此属性设置为1并且没有DqlPartitionFunctionbean,则所有死信记录都将写入分区0。如果此属性大于1,则您必须提供一个DlqPartitionFunctionbean。请注意,实际分区计数受 binder 的minPartitionCount属性影响。默认值:

none - configuration

-

包含通用 Kafka 消费者属性的键/值对映射。除了 Kafka 消费者属性外,此处还可以传递其他配置属性。例如,应用程序所需的一些属性,如

spring.cloud.stream.kafka.bindings.input.consumer.configuration.foo=bar。此处不能设置bootstrap.servers属性;如果需要连接到多个集群,请使用多 binder 支持。默认值:空映射。

- dlqName

-

用于接收错误消息的 DLQ 主题名称。

默认值:null(如果未指定,导致错误的消息将转发到名为

error.<destination>.<group>的主题)。 - dlqProducerProperties

-

通过此属性,可以设置 DLQ 特定的生产者属性。所有可通过 Kafka 生产者属性获得的属性都可以通过此属性进行设置。当消费者上启用原生解码(即 useNativeDecoding: true)时,应用程序必须为 DLQ 提供相应的键/值序列化器。这必须以

dlqProducerProperties.configuration.key.serializer和dlqProducerProperties.configuration.value.serializer的形式提供。默认值:默认 Kafka 生产者属性。

- standardHeaders

-

指示入站通道适配器填充哪些标准头。允许的值:

none、id、timestamp或both。如果使用原生反序列化且接收消息的第一个组件需要一个id(例如配置为使用 JDBC 消息存储的聚合器),则此功能很有用。默认值:

none - converterBeanName

-

实现

RecordMessageConverter的 bean 的名称。在入站通道适配器中用于替换默认的MessagingMessageConverter。默认值:

null - idleEventInterval

-

指示最近没有收到消息的事件之间的间隔,以毫秒为单位。使用

ApplicationListener<ListenerContainerIdleEvent>来接收这些事件。有关使用示例,请参阅示例:暂停和恢复消费者。默认值:

30000 - destinationIsPattern

-

当为 true 时,目标被视为一个正则表达式

Pattern,用于由代理匹配主题名称。当为 true 时,不提供主题,并且不允许enableDlq,因为 binder 在 provisioning 阶段不知道主题名称。请注意,检测与模式匹配的新主题所需的时间由消费者属性metadata.max.age.ms控制,该属性(在撰写本文时)默认为 300,000 毫秒(5 分钟)。这可以使用上面的configuration属性进行配置。默认值:

false - topic.properties

-

在配置新主题时使用的 Kafka 主题属性的

Map,例如spring.cloud.stream.kafka.bindings.input.consumer.topic.properties.message.format.version=0.9.0.0默认值:无。

- topic.replicas-assignment

-

副本分配的 Map<Integer, List<Integer>>,其中键是分区,值是分配。在配置新主题时使用。请参阅

kafka-clientsjar 中的NewTopicJavadoc。默认值:无。

- topic.replication-factor

-

配置主题时使用的复制因子。覆盖 binder 范围的设置。如果存在

replicas-assignments则忽略。默认值:无(使用 binder 范围的默认值 -1)。

- pollTimeout

-

可轮询消费者中轮询使用的超时时间。

默认值:5 秒。

- 事务管理器

-

KafkaAwareTransactionManager的 bean 名称,用于覆盖此绑定的 binder 事务管理器。通常在您希望使用ChainedKafkaTransactionManaager将另一个事务与 Kafka 事务同步时需要。要实现记录的精确一次消费和生产,消费者和生产者绑定必须都配置相同的事务管理器。默认值:无。

- txCommitRecovered

-

使用事务性 binder 时,恢复记录的偏移量(例如,当重试耗尽且记录发送到死信主题时)将默认通过新事务提交。将此属性设置为

false将抑制恢复记录的偏移量提交。默认值:true。

- commonErrorHandlerBeanName

-

每个消费者绑定要使用的

CommonErrorHandlerbean 名称。如果存在,此用户提供的CommonErrorHandler将优先于 binder 定义的任何其他错误处理器。如果应用程序不想使用ListenerContainerCustomizer然后检查目标/组组合来设置错误处理器,这是一种方便表达错误处理器的方式。默认值:无。

1.3.3. 重置偏移量

当应用程序启动时,每个分配的分区中的初始位置取决于两个属性 startOffset 和 resetOffsets。如果 resetOffsets 为 false,则应用正常的 Kafka 消费者 auto.offset.reset 语义。即,如果绑定消费者组的分区没有提交的偏移量,则位置为 earliest 或 latest。默认情况下,具有显式 group 的绑定使用 earliest,匿名绑定(没有 group)使用 latest。这些默认值可以通过设置 startOffset 绑定属性来覆盖。首次使用特定 group 启动绑定时,将没有提交的偏移量。没有提交偏移量的另一种情况是偏移量已过期。对于现代代理(自 2.1 版本起),以及默认代理属性,偏移量在最后一个成员离开组后 7 天过期。有关更多信息,请参阅 offsets.retention.minutes 代理属性。

当 resetOffsets 为 true 时,binder 应用与代理上没有提交偏移量时类似的语义,就像此绑定从未从主题消费过一样;即,任何当前的提交偏移量都将被忽略。

以下是可能使用此功能两种情况。

-

从包含键/值对的压缩主题消费。将

resetOffsets设置为true并将startOffset设置为earliest;绑定将对所有新分配的分区执行seekToBeginning。 -

从包含事件的主题消费,您只对在此绑定运行时发生的事件感兴趣。将

resetOffsets设置为true并将startOffset设置为latest;绑定将对所有新分配的分区执行seekToEnd。

| 如果在初始分配后发生再平衡,则寻求仅对在初始分配期间未分配的任何新分配的分区执行。 |

有关主题偏移量的更多控制,请参阅使用 KafkaBindingRebalanceListener;当提供侦听器时,不应将 resetOffsets 设置为 true,否则将导致错误。

1.3.4. 消费批次

从 3.0 版本开始,当 spring.cloud.stream.binding.<name>.consumer.batch-mode 设置为 true 时,通过轮询 Kafka Consumer 接收到的所有记录都将以 List<?> 的形式呈现给侦听器方法。否则,方法将一次调用一个记录。批处理的大小由 Kafka 消费者属性 max.poll.records、fetch.min.bytes、fetch.max.wait.ms 控制;有关详细信息,请参阅 Kafka 文档。

请记住,批处理模式不支持 @StreamListener - 它仅适用于较新的函数式编程模型。

在批处理模式下不支持 binder 内的重试,因此 maxAttempts 将被覆盖为 1。您可以配置一个 SeekToCurrentBatchErrorHandler(使用 ListenerContainerCustomizer)以实现与 binder 中重试类似的功能。您还可以使用手动 AckMode 并调用 Ackowledgment.nack(index, sleep) 来提交部分批次的偏移量,并重新传递剩余的记录。有关这些技术的更多信息,请参阅 Spring for Apache Kafka 文档。 |

1.3.5. Kafka 生产者属性

为避免重复,Spring Cloud Stream 支持以 spring.cloud.stream.kafka.default.producer.<property>=<value> 的格式为所有通道设置值。 |

以下属性仅适用于 Kafka 生产者,并且必须以 spring.cloud.stream.kafka.bindings.<channelName>.producer. 为前缀。

- admin.configuration

-

自 2.1.1 版起,此属性已弃用,取而代之的是

topic.properties,并将在未来版本中移除对其的支持。 - admin.replicas-assignment

-

自 2.1.1 版起,此属性已弃用,取而代之的是

topic.replicas-assignment,并将在未来版本中移除对其的支持。 - admin.replication-factor

-

自 2.1.1 版起,此属性已弃用,取而代之的是

topic.replication-factor,并将在未来版本中移除对其的支持。 - bufferSize

-

Kafka 生产者在发送之前尝试批量处理的数据量的上限,以字节为单位。

默认值:

16384。 - sync

-

生产者是否同步。

默认值:

false。 - sendTimeoutExpression

-

对出站消息求值的 SpEL 表达式,用于评估启用同步发布时等待 ack 的时间——例如,

headers['mySendTimeout']。超时值以毫秒为单位。在 3.0 之前的版本中,除非使用原生编码,否则无法使用有效负载,因为在评估此表达式时,有效负载已经是byte[]的形式。现在,在转换有效负载之前评估表达式。默认值:

none。 - batchTimeout

-

生产者等待更多消息累积在同一批次中然后发送消息的时间。(通常,生产者根本不会等待,而只是发送在前一次发送进行中累积的所有消息。)非零值可能会以延迟为代价提高吞吐量。

默认值:

0。 - messageKeyExpression

-

一个针对出站消息进行评估的 SpEL 表达式,用于填充生成的 Kafka 消息的键——例如,

headers['myKey']。在 3.0 之前的版本中,除非使用原生编码,否则无法使用有效负载,因为在评估此表达式时,有效负载已经是byte[]的形式。现在,在转换有效负载之前评估表达式。对于常规处理器 (Function<String, String>或Function<Message<?>, Message<?>),如果生成的键需要与主题中的传入键相同,则可以按如下方式设置此属性。spring.cloud.stream.kafka.bindings.<output-binding-name>.producer.messageKeyExpression: headers['kafka_receivedMessageKey']对于响应式函数有一个重要的注意事项。在这种情况下,应用程序需要手动将传入消息中的头复制到出站消息中。您可以设置头,例如myKey,并使用headers['myKey'],如上所述,或者为了方便起见,只需设置KafkaHeaders.MESSAGE_KEY头,您根本不需要设置此属性。默认值:

none。 - headerPatterns

-

一个逗号分隔的简单模式列表,用于匹配 Spring 消息头,这些消息头将映射到

ProducerRecord中的 KafkaHeaders。模式可以以通配符(星号)开头或结尾。模式可以通过前缀!来否定。匹配在第一次匹配(肯定或否定)后停止。例如!ask,as*将通过ash但不通过ask。id和timestamp永远不会映射。默认值:

*(所有头 - 除了id和timestamp) - configuration

-

包含通用 Kafka 生产者属性的键/值对映射。此处不能设置

bootstrap.servers属性;如果需要连接到多个集群,请使用多 binder 支持。默认值:空映射。

- topic.properties

-

在配置新主题时使用的 Kafka 主题属性的

Map,例如spring.cloud.stream.kafka.bindings.output.producer.topic.properties.message.format.version=0.9.0.0 - topic.replicas-assignment

-

副本分配的 Map<Integer, List<Integer>>,其中键是分区,值是分配。在配置新主题时使用。请参阅

kafka-clientsjar 中的NewTopicJavadoc。默认值:无。

- topic.replication-factor

-

配置主题时使用的复制因子。覆盖 binder 范围的设置。如果存在

replicas-assignments则忽略。默认值:无(使用 binder 范围的默认值 -1)。

- useTopicHeader

-

设置为

true以使用出站消息中的KafkaHeaders.TOPIC消息头的值覆盖默认绑定目标(主题名称)。如果不存在该头,则使用默认绑定目标。默认值:

false。 - recordMetadataChannel

-

用于发送成功发送结果的

MessageChannel的 bean 名称;该 bean 必须存在于应用程序上下文中。发送到通道的消息是已发送消息(如果进行了转换,则为转换后的消息),并带有一个额外的头KafkaHeaders.RECORD_METADATA。该头包含 Kafka 客户端提供的RecordMetadata对象;它包括记录写入主题的分区和偏移量。ResultMetadata meta = sendResultMsg.getHeaders().get(KafkaHeaders.RECORD_METADATA, RecordMetadata.class)失败的发送将发送到生产者错误通道(如果已配置);请参阅错误通道。

默认值:null。

Kafka binder 使用生产者的 partitionCount 设置作为提示来创建具有给定分区计数的主题(结合 minPartitionCount,两者中的最大值将用作实际值)。在为 binder 配置 minPartitionCount 和为应用程序配置 partitionCount 时要谨慎,因为将使用较大的值。如果主题已存在且分区计数较小,并且 autoAddPartitions 被禁用(默认),则 binder 将无法启动。如果主题已存在且分区计数较小,并且 autoAddPartitions 被启用,则会添加新分区。如果主题已存在且分区数量大于 minPartitionCount 或 partitionCount 的最大值,则将使用现有分区计数。 |

- compression

-

设置

compression.type生产者属性。支持的值为none、gzip、snappy、lz4和zstd。如果您将kafka-clientsjar 覆盖为 2.1.0(或更高版本),如 Spring for Apache Kafka 文档中所述,并希望使用zstd压缩,请使用spring.cloud.stream.kafka.bindings.<binding-name>.producer.configuration.compression.type=zstd。默认值:

none。 - 事务管理器

-

KafkaAwareTransactionManager的 bean 名称,用于覆盖此绑定的 binder 事务管理器。通常在您希望使用ChainedKafkaTransactionManaager将另一个事务与 Kafka 事务同步时需要。要实现记录的精确一次消费和生产,消费者和生产者绑定必须都配置相同的事务管理器。默认值:无。

- closeTimeout

-

关闭生产者时等待的超时时间,以秒为单位。

默认值:

30 - allowNonTransactional

-

通常,与事务性 binder 关联的所有输出绑定都将在新事务中发布,如果尚未进行事务。此属性允许您覆盖该行为。如果设置为 true,则发布到此输出绑定的记录将不会在事务中运行,除非事务已经进行中。

默认值:

false

1.3.6. 使用示例

在本节中,我们将展示前面属性在特定场景中的使用。

示例:将 ackMode 设置为 MANUAL 并依赖手动确认

此示例说明了如何在消费者应用程序中手动确认偏移量。

此示例要求将 spring.cloud.stream.kafka.bindings.input.consumer.ackMode 设置为 MANUAL。请为您的示例使用相应的输入通道名称。

@SpringBootApplication

@EnableBinding(Sink.class)

public class ManuallyAcknowdledgingConsumer {

public static void main(String[] args) {

SpringApplication.run(ManuallyAcknowdledgingConsumer.class, args);

}

@StreamListener(Sink.INPUT)

public void process(Message<?> message) {

Acknowledgment acknowledgment = message.getHeaders().get(KafkaHeaders.ACKNOWLEDGMENT, Acknowledgment.class);

if (acknowledgment != null) {

System.out.println("Acknowledgment provided");

acknowledgment.acknowledge();

}

}

}示例:安全配置

Apache Kafka 0.9 支持客户端和代理之间的安全连接。要利用此功能,请遵循 Apache Kafka 文档中的指南以及 Confluent 文档中 Kafka 0.9 安全指南。使用 spring.cloud.stream.kafka.binder.configuration 选项为 binder 创建的所有客户端设置安全属性。

例如,要将 security.protocol 设置为 SASL_SSL,请设置以下属性

spring.cloud.stream.kafka.binder.configuration.security.protocol=SASL_SSL所有其他安全属性也可以以类似的方式设置。

使用 Kerberos 时,请遵循 参考文档中的说明来创建和引用 JAAS 配置。

Spring Cloud Stream 支持通过使用 JAAS 配置文件和 Spring Boot 属性将 JAAS 配置信息传递给应用程序。

使用 JAAS 配置文件

通过使用系统属性,可以为 Spring Cloud Stream 应用程序设置 JAAS 和(可选)krb5 文件位置。以下示例演示了如何使用 JAAS 配置文件启动带 SASL 和 Kerberos 的 Spring Cloud Stream 应用程序

java -Djava.security.auth.login.config=/path.to/kafka_client_jaas.conf -jar log.jar \

--spring.cloud.stream.kafka.binder.brokers=secure.server:9092 \

--spring.cloud.stream.bindings.input.destination=stream.ticktock \

--spring.cloud.stream.kafka.binder.configuration.security.protocol=SASL_PLAINTEXT使用 Spring Boot 属性

作为 JAAS 配置文件的替代方案,Spring Cloud Stream 提供了一种机制,允许使用 Spring Boot 属性为 Spring Cloud Stream 应用程序设置 JAAS 配置。

以下属性可用于配置 Kafka 客户端的登录上下文

- spring.cloud.stream.kafka.binder.jaas.loginModule

-

登录模块名称。在正常情况下无需设置。

默认值:

com.sun.security.auth.module.Krb5LoginModule。 - spring.cloud.stream.kafka.binder.jaas.controlFlag

-

登录模块的控制标志。

默认值:

required。 - spring.cloud.stream.kafka.binder.jaas.options

-

包含登录模块选项的键/值对映射。

默认值:空映射。

以下示例演示了如何使用 Spring Boot 配置属性启动带 SASL 和 Kerberos 的 Spring Cloud Stream 应用程序

java --spring.cloud.stream.kafka.binder.brokers=secure.server:9092 \

--spring.cloud.stream.bindings.input.destination=stream.ticktock \

--spring.cloud.stream.kafka.binder.autoCreateTopics=false \

--spring.cloud.stream.kafka.binder.configuration.security.protocol=SASL_PLAINTEXT \

--spring.cloud.stream.kafka.binder.jaas.options.useKeyTab=true \

--spring.cloud.stream.kafka.binder.jaas.options.storeKey=true \

--spring.cloud.stream.kafka.binder.jaas.options.keyTab=/etc/security/keytabs/kafka_client.keytab \

--spring.cloud.stream.kafka.binder.jaas.options.principal=kafka-client-1@EXAMPLE.COM前面的示例表示以下 JAAS 文件的等价物

KafkaClient {

com.sun.security.auth.module.Krb5LoginModule required

useKeyTab=true

storeKey=true

keyTab="/etc/security/keytabs/kafka_client.keytab"

principal="[email protected]";

};如果所需主题已存在于代理上或将由管理员创建,则可以关闭自动创建,并且只需要发送客户端 JAAS 属性。

不要在同一个应用程序中混合使用 JAAS 配置文件和 Spring Boot 属性。如果 -Djava.security.auth.login.config 系统属性已存在,Spring Cloud Stream 将忽略 Spring Boot 属性。 |

在使用 Kerberos 时,请谨慎使用 autoCreateTopics 和 autoAddPartitions。通常,应用程序可能使用在 Kafka 和 Zookeeper 中没有管理权限的主体。因此,依赖 Spring Cloud Stream 创建/修改主题可能会失败。在安全环境中,我们强烈建议使用 Kafka 工具以管理方式创建主题和管理 ACL。 |

多 binder 配置和 JAAS

当连接到需要单独 JAAS 配置的多个集群时,请使用属性 sasl.jaas.config 设置 JAAS 配置。当此属性存在于应用程序中时,它将优先于上面提到的其他策略。有关更多详细信息,请参阅此 KIP-85。

例如,如果您的应用程序中有两个集群,每个集群都有单独的 JAAS 配置,那么以下是您可以使用的模板

spring.cloud.stream:

binders:

kafka1:

type: kafka

environment:

spring:

cloud:

stream:

kafka:

binder:

brokers: localhost:9092

configuration.sasl.jaas.config: "org.apache.kafka.common.security.plain.PlainLoginModule required username=\"admin\" password=\"admin-secret\";"

kafka2:

type: kafka

environment:

spring:

cloud:

stream:

kafka:

binder:

brokers: localhost:9093

configuration.sasl.jaas.config: "org.apache.kafka.common.security.plain.PlainLoginModule required username=\"user1\" password=\"user1-secret\";"

kafka.binder:

configuration:

security.protocol: SASL_PLAINTEXT

sasl.mechanism: PLAIN请注意,在上述配置中,两个 Kafka 集群及其各自的 sasl.jaas.config 值都是不同的。

有关如何设置和运行此类应用程序的更多详细信息,请参阅此示例应用程序。

示例:暂停和恢复消费者

如果您希望暂停消费但不引起分区再平衡,您可以暂停和恢复消费者。这通过管理绑定生命周期来实现,如 Spring Cloud Stream 文档中 绑定可视化和控制 所示,使用 State.PAUSED 和 State.RESUMED。

要恢复,您可以使用 ApplicationListener(或 @EventListener 方法)接收 ListenerContainerIdleEvent 实例。事件发布的频率由 idleEventInterval 属性控制。

1.4. 事务性 Binder

通过将 spring.cloud.stream.kafka.binder.transaction.transactionIdPrefix 设置为非空值(例如 tx-)来启用事务。当在处理器应用程序中使用时,消费者启动事务;消费者线程上发送的任何记录都参与相同的事务。当侦听器正常退出时,侦听器容器将偏移量发送到事务并提交。所有使用 spring.cloud.stream.kafka.binder.transaction.producer.* 属性配置的生产者绑定都使用一个通用的生产者工厂;单个绑定 Kafka 生产者属性将被忽略。

事务不支持常规 binder 重试(和死信),因为重试将在原始事务中运行,该事务可能会回滚,并且任何已发布的记录也将回滚。启用重试时(通用属性 maxAttempts 大于零),重试属性用于配置 DefaultAfterRollbackProcessor 以启用容器级别的重试。同样,死信记录的发布不再在事务中进行,此功能已转移到侦听器容器,再次通过 DefaultAfterRollbackProcessor,它在主事务回滚后运行。 |

如果您希望在源应用程序中使用事务,或者从某个任意线程进行仅生产者事务(例如 @Scheduled 方法),则必须获取事务性生产者工厂的引用并使用它定义 KafkaTransactionManager bean。

@Bean

public PlatformTransactionManager transactionManager(BinderFactory binders,

@Value("${unique.tx.id.per.instance}") String txId) {

ProducerFactory<byte[], byte[]> pf = ((KafkaMessageChannelBinder) binders.getBinder(null,

MessageChannel.class)).getTransactionalProducerFactory();

KafkaTransactionManager tm = new KafkaTransactionManager<>(pf);

tm.setTransactionId(txId)

return tm;

}请注意,我们使用 BinderFactory 获取 binder 的引用;当只有一个 binder 配置时,第一个参数使用 null。如果配置了多个 binder,则使用 binder 名称获取引用。一旦我们获得了 binder 的引用,我们就可以获取 ProducerFactory 的引用并创建事务管理器。

然后您将使用正常的 Spring 事务支持,例如 TransactionTemplate 或 @Transactional,例如

public static class Sender {

@Transactional

public void doInTransaction(MessageChannel output, List<String> stuffToSend) {

stuffToSend.forEach(stuff -> output.send(new GenericMessage<>(stuff)));

}

}如果您希望将仅生产者事务与来自其他事务管理器的事务同步,请使用 ChainedTransactionManager。

如果您部署应用程序的多个实例,每个实例都需要唯一的 transactionIdPrefix。 |

1.5. 错误通道

从 1.3 版本开始,binder 无条件地将异常发送到每个消费者目标的错误通道,并且还可以配置为将异步生产者发送失败发送到错误通道。有关更多信息,请参阅有关错误处理的这一部分。

发送失败的 ErrorMessage 的有效负载是 KafkaSendFailureException,其属性为

-

failedMessage:发送失败的 Spring MessagingMessage<?>。 -

record:从failedMessage创建的原始ProducerRecord

没有自动处理生产者异常(例如发送到死信队列)。您可以使用自己的 Spring Integration 流来处理这些异常。

1.6. Kafka 指标

Kafka binder 模块暴露以下指标

spring.cloud.stream.binder.kafka.offset:此指标指示给定消费者组从给定 binder 主题中尚未消费的消息数量。提供的指标基于 Micrometer 库。如果 Micrometer 在 classpath 中,并且应用程序未提供其他此类 bean,则 binder 会创建 KafkaBinderMetrics bean。该指标包含消费者组信息、主题和已提交偏移量与主题最新偏移量之间的实际滞后。此指标对于向 PaaS 平台提供自动伸缩反馈特别有用。

您可以通过在应用程序中提供以下组件来阻止 KafkaBinderMetrics 创建必要的基础设施(例如消费者)并报告指标。

@Component

class NoOpBindingMeters {

NoOpBindingMeters(MeterRegistry registry) {

registry.config().meterFilter(

MeterFilter.denyNameStartsWith(KafkaBinderMetrics.OFFSET_LAG_METRIC_NAME));

}

}有关如何选择性地抑制仪表的更多详细信息,请参阅此处。

1.7. 墓碑记录 (空记录值)

使用压缩主题时,值为 null 的记录(也称为墓碑记录)表示键的删除。要在 @StreamListener 方法中接收此类消息,参数必须标记为非必需才能接收 null 值参数。

@StreamListener(Sink.INPUT)

public void in(@Header(KafkaHeaders.RECEIVED_MESSAGE_KEY) byte[] key,

@Payload(required = false) Customer customer) {

// customer is null if a tombstone record

...

}1.8. 使用 KafkaBindingRebalanceListener

应用程序可能希望在分区最初分配时将主题/分区定位到任意偏移量,或对消费者执行其他操作。从 2.1 版本开始,如果您在应用程序上下文中提供一个 KafkaBindingRebalanceListener bean,它将被连接到所有 Kafka 消费者绑定中。

public interface KafkaBindingRebalanceListener {

/**

* Invoked by the container before any pending offsets are committed.

* @param bindingName the name of the binding.

* @param consumer the consumer.

* @param partitions the partitions.

*/

default void onPartitionsRevokedBeforeCommit(String bindingName, Consumer<?, ?> consumer,

Collection<TopicPartition> partitions) {

}

/**

* Invoked by the container after any pending offsets are committed.

* @param bindingName the name of the binding.

* @param consumer the consumer.

* @param partitions the partitions.

*/

default void onPartitionsRevokedAfterCommit(String bindingName, Consumer<?, ?> consumer, Collection<TopicPartition> partitions) {

}

/**

* Invoked when partitions are initially assigned or after a rebalance.

* Applications might only want to perform seek operations on an initial assignment.

* @param bindingName the name of the binding.

* @param consumer the consumer.

* @param partitions the partitions.

* @param initial true if this is the initial assignment.

*/

default void onPartitionsAssigned(String bindingName, Consumer<?, ?> consumer, Collection<TopicPartition> partitions,

boolean initial) {

}

}提供再平衡侦听器时,不能将 resetOffsets 消费者属性设置为 true。

1.9. 重试和死信处理

默认情况下,当您在消费者绑定中配置重试(例如 maxAttemts)和 enableDlq 时,这些功能在 binder 内部执行,不参与侦听器容器或 Kafka 消费者。

在某些情况下,将此功能移到侦听器容器中更可取,例如

-

重试和延迟的总和将超过消费者的

max.poll.interval.ms属性,可能导致分区再平衡。 -

您希望将死信发布到不同的 Kafka 集群。

-

您希望向错误处理器添加重试侦听器。

-

…

要配置将此功能从 binder 移动到容器,请定义类型为 ListenerContainerWithDlqAndRetryCustomizer 的 @Bean。此接口具有以下方法

/**

* Configure the container.

* @param container the container.

* @param destinationName the destination name.

* @param group the group.

* @param dlqDestinationResolver a destination resolver for the dead letter topic (if

* enableDlq).

* @param backOff the backOff using retry properties (if configured).

* @see #retryAndDlqInBinding(String, String)

*/

void configure(AbstractMessageListenerContainer<?, ?> container, String destinationName, String group,

@Nullable BiFunction<ConsumerRecord<?, ?>, Exception, TopicPartition> dlqDestinationResolver,

@Nullable BackOff backOff);

/**

* Return false to move retries and DLQ from the binding to a customized error handler

* using the retry metadata and/or a {@code DeadLetterPublishingRecoverer} when

* configured via

* {@link #configure(AbstractMessageListenerContainer, String, String, BiFunction, BackOff)}.

* @param destinationName the destination name.

* @param group the group.

* @return true to disable retrie in the binding

*/

default boolean retryAndDlqInBinding(String destinationName, String group) {

return true;

}目标解析器和 BackOff 是根据绑定属性(如果已配置)创建的。然后,您可以使用它们来创建自定义错误处理器和死信发布器;例如

@Bean

ListenerContainerWithDlqAndRetryCustomizer cust(KafkaTemplate<?, ?> template) {

return new ListenerContainerWithDlqAndRetryCustomizer() {

@Override

public void configure(AbstractMessageListenerContainer<?, ?> container, String destinationName,

String group,

@Nullable BiFunction<ConsumerRecord<?, ?>, Exception, TopicPartition> dlqDestinationResolver,

@Nullable BackOff backOff) {

if (destinationName.equals("topicWithLongTotalRetryConfig")) {

ConsumerRecordRecoverer dlpr = new DeadLetterPublishingRecoverer(template),

dlqDestinationResolver);

container.setCommonErrorHandler(new DefaultErrorHandler(dlpr, backOff));

}

}

@Override

public boolean retryAndDlqInBinding(String destinationName, String group) {

return !destinationName.contains("topicWithLongTotalRetryConfig");

}

};

}现在,只需要一个重试延迟大于消费者的 max.poll.interval.ms 属性。

1.10. 自定义消费者和生产者配置

如果您想对用于在 Kafka 中创建 ConsumerFactory 和 ProducerFactory 的消费者和生产者配置进行高级自定义,您可以实现以下定制器。

-

ConsumerConfigCustomizer

-

ProducerConfigCustomizer

这两个接口都提供了一种配置用于消费者和生产者属性的配置映射的方法。例如,如果您想访问在应用程序级别定义的 bean,您可以将其注入 configure 方法的实现中。当 binder 发现这些定制器可用作 bean 时,它将在创建消费者和生产者工厂之前调用 configure 方法。

这两个接口还提供了对绑定和目标名称的访问,以便在自定义生产者和消费者属性时可以访问它们。

1.11. 自定义 AdminClient 配置

与上述消费者和生产者配置定制一样,应用程序还可以通过提供 AdminClientConfigCustomizer 来定制 AdminClient 的配置。AdminClientConfigCustomizer 的 configure 方法提供了对 AdminClient 属性的访问,您可以使用这些属性进行进一步的定制。Binder 的 Kafka 主题供应器对此定制器提供的属性给予最高优先级。以下是提供此定制器 bean 的示例。

@Bean

public AdminClientConfigCustomizer adminClientConfigCustomizer() {

return props -> {

props.put(CommonClientConfigs.SECURITY_PROTOCOL_CONFIG, "SASL_SSL");

};

}1.12. 自定义 Kafka Binder 健康指示器

当 Spring Boot Actuator 在类路径上时,Kafka binder 会激活一个默认的健康指示器。此健康指示器检查 binder 的健康状况以及与 Kafka 代理的任何通信问题。如果应用程序想要禁用此默认健康检查实现并包含自定义实现,则可以为 KafkaBinderHealth 接口提供一个实现。KafkaBinderHealth 是一个扩展自 HealthIndicator 的标记接口。在自定义实现中,它必须提供 health() 方法的实现。自定义实现必须以 bean 的形式存在于应用程序配置中。当 binder 发现自定义实现时,它将使用它而不是默认实现。以下是应用程序中此类自定义实现 bean 的示例。

@Bean

public KafkaBinderHealth kafkaBinderHealthIndicator() {

return new KafkaBinderHealth() {

@Override

public Health health() {

// custom implementation details.

}

};

}1.13. 死信主题处理

1.13.1. 死信主题分区选择

默认情况下,记录发布到死信主题时使用与原始记录相同的分区。这意味着死信主题必须至少有与原始记录相同数量的分区。

要更改此行为,请将 DlqPartitionFunction 实现作为 @Bean 添加到应用程序上下文。只能存在一个这样的 bean。该函数将提供消费者组、失败的 ConsumerRecord 和异常。例如,如果您总是希望路由到分区 0,您可以使用

@Bean

public DlqPartitionFunction partitionFunction() {

return (group, record, ex) -> 0;

}如果您将消费者绑定的 dlqPartitions 属性设置为 1(并且绑定的 minPartitionCount 等于 1),则无需提供 DlqPartitionFunction;框架将始终使用分区 0。如果您将消费者绑定的 dlqPartitions 属性设置为大于 1 的值(或绑定的 minPartitionCount 大于 1),则您必须提供一个 DlqPartitionFunction bean,即使分区计数与原始主题相同。 |

还可以为 DLQ 主题定义自定义名称。为此,请将 DlqDestinationResolver 的实现作为 @Bean 创建到应用程序上下文。当 binder 检测到此类 bean 时,它将优先使用,否则它将使用 dlqName 属性。如果两者都未找到,它将默认为 error.<destination>.<group>。以下是 DlqDestinationResolver 作为 @Bean 的示例。

@Bean

public DlqDestinationResolver dlqDestinationResolver() {

return (rec, ex) -> {

if (rec.topic().equals("word1")) {

return "topic1-dlq";

}

else {

return "topic2-dlq";

}

};

}在提供 DlqDestinationResolver 的实现时,需要记住一件重要的事情,那就是绑定器中的 provisioner 不会自动为应用程序创建主题。这是因为绑定器无法推断出实现可能发送到的所有 DLQ 主题的名称。因此,如果您使用此策略提供 DLQ 名称,应用程序有责任确保这些主题事先已创建。

1.13.2. 处理死信主题中的记录

由于框架无法预测用户希望如何处理死信消息,因此它不提供任何标准机制来处理它们。如果死信的原因是暂时的,您可能希望将消息路由回原始主题。但是,如果问题是永久性问题,那可能会导致无限循环。本主题中的示例 Spring Boot 应用程序是一个示例,说明如何将这些消息路由回原始主题,但在三次尝试后将其移动到“停放”主题。该应用程序是另一个从死信主题读取的 spring-cloud-stream 应用程序。当 5 秒内没有收到消息时,它会退出。

示例假设原始目标是 so8400out,消费者组是 so8400。

有几种策略需要考虑

-

考虑仅在主应用程序未运行时运行重定向。否则,瞬态错误的重试将很快耗尽。

-

或者,采用两阶段方法:使用此应用程序路由到第三个主题,并使用另一个应用程序从该主题路由回主主题。

以下代码清单显示了示例应用程序

spring.cloud.stream.bindings.input.group=so8400replay

spring.cloud.stream.bindings.input.destination=error.so8400out.so8400

spring.cloud.stream.bindings.output.destination=so8400out

spring.cloud.stream.bindings.parkingLot.destination=so8400in.parkingLot

spring.cloud.stream.kafka.binder.configuration.auto.offset.reset=earliest

spring.cloud.stream.kafka.binder.headers=x-retries@SpringBootApplication

@EnableBinding(TwoOutputProcessor.class)

public class ReRouteDlqKApplication implements CommandLineRunner {

private static final String X_RETRIES_HEADER = "x-retries";

public static void main(String[] args) {

SpringApplication.run(ReRouteDlqKApplication.class, args).close();

}

private final AtomicInteger processed = new AtomicInteger();

@Autowired

private MessageChannel parkingLot;

@StreamListener(Processor.INPUT)

@SendTo(Processor.OUTPUT)

public Message<?> reRoute(Message<?> failed) {

processed.incrementAndGet();

Integer retries = failed.getHeaders().get(X_RETRIES_HEADER, Integer.class);

if (retries == null) {

System.out.println("First retry for " + failed);

return MessageBuilder.fromMessage(failed)

.setHeader(X_RETRIES_HEADER, new Integer(1))

.setHeader(BinderHeaders.PARTITION_OVERRIDE,

failed.getHeaders().get(KafkaHeaders.RECEIVED_PARTITION_ID))

.build();

}

else if (retries.intValue() < 3) {

System.out.println("Another retry for " + failed);

return MessageBuilder.fromMessage(failed)

.setHeader(X_RETRIES_HEADER, new Integer(retries.intValue() + 1))

.setHeader(BinderHeaders.PARTITION_OVERRIDE,

failed.getHeaders().get(KafkaHeaders.RECEIVED_PARTITION_ID))

.build();

}

else {

System.out.println("Retries exhausted for " + failed);

parkingLot.send(MessageBuilder.fromMessage(failed)

.setHeader(BinderHeaders.PARTITION_OVERRIDE,

failed.getHeaders().get(KafkaHeaders.RECEIVED_PARTITION_ID))

.build());

}

return null;

}

@Override

public void run(String... args) throws Exception {

while (true) {

int count = this.processed.get();

Thread.sleep(5000);

if (count == this.processed.get()) {

System.out.println("Idle, exiting");

return;

}

}

}

public interface TwoOutputProcessor extends Processor {

@Output("parkingLot")

MessageChannel parkingLot();

}

}1.14. 使用 Kafka Binder 进行分区

Apache Kafka 原生支持主题分区。

有时将数据发送到特定分区是有利的——例如,当您希望严格排序消息处理时(特定客户的所有消息都应发送到同一分区)。

以下示例演示了如何配置生产者和消费者端

@SpringBootApplication

@EnableBinding(Source.class)

public class KafkaPartitionProducerApplication {

private static final Random RANDOM = new Random(System.currentTimeMillis());

private static final String[] data = new String[] {

"foo1", "bar1", "qux1",

"foo2", "bar2", "qux2",

"foo3", "bar3", "qux3",

"foo4", "bar4", "qux4",

};

public static void main(String[] args) {

new SpringApplicationBuilder(KafkaPartitionProducerApplication.class)

.web(false)

.run(args);

}

@InboundChannelAdapter(channel = Source.OUTPUT, poller = @Poller(fixedRate = "5000"))

public Message<?> generate() {

String value = data[RANDOM.nextInt(data.length)];

System.out.println("Sending: " + value);

return MessageBuilder.withPayload(value)

.setHeader("partitionKey", value)

.build();

}

}spring:

cloud:

stream:

bindings:

output:

destination: partitioned.topic

producer:

partition-key-expression: headers['partitionKey']

partition-count: 12主题必须配置足够的分区,以实现所有消费者组所需的并发性。上述配置支持多达 12 个消费者实例(如果其 concurrency 为 2,则为 6 个;如果其并发为 3,则为 4 个,依此类推)。通常最好“过度配置”分区,以允许未来增加消费者或并发性。 |

上述配置使用默认分区 (key.hashCode() % partitionCount)。这可能提供也可能不提供适当平衡的算法,具体取决于键值。您可以通过使用 partitionSelectorExpression 或 partitionSelectorClass 属性来覆盖此默认值。 |

由于分区由 Kafka 原生处理,因此消费者端不需要特殊配置。Kafka 在实例之间分配分区。

以下 Spring Boot 应用程序监听 Kafka 流并将(到控制台)每条消息进入的分区 ID 打印出来

@SpringBootApplication

@EnableBinding(Sink.class)

public class KafkaPartitionConsumerApplication {

public static void main(String[] args) {

new SpringApplicationBuilder(KafkaPartitionConsumerApplication.class)

.web(false)

.run(args);

}

@StreamListener(Sink.INPUT)

public void listen(@Payload String in, @Header(KafkaHeaders.RECEIVED_PARTITION_ID) int partition) {

System.out.println(in + " received from partition " + partition);

}

}spring:

cloud:

stream:

bindings:

input:

destination: partitioned.topic

group: myGroup您可以根据需要添加实例。Kafka 会重新平衡分区分配。如果实例计数(或 实例计数 * 并发数)超过分区数,则某些消费者将处于空闲状态。

2. Kafka Streams Binder

2.1. 用法

要使用 Kafka Streams binder,您只需将其添加到 Spring Cloud Stream 应用程序中,使用以下 maven 坐标

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-stream-binder-kafka-streams</artifactId>

</dependency>快速启动 Kafka Streams binder 新项目的方法是使用 Spring Initializr,然后选择“Cloud Streams”和“Spring for Kafka Streams”,如下图所示

2.2. 概览

Spring Cloud Stream 包含一个专门为 Apache Kafka Streams 绑定设计的 binder 实现。通过此原生集成,Spring Cloud Stream“处理器”应用程序可以直接在核心业务逻辑中使用 Apache Kafka Streams API。

Kafka Streams binder 实现建立在 Spring for Apache Kafka 项目提供的基础上。

Kafka Streams binder 为 Kafka Streams 中的三种主要类型提供绑定功能 - KStream、KTable 和 GlobalKTable。

Kafka Streams 应用程序通常遵循一种模型,其中从入站主题读取记录,应用业务逻辑,然后将转换后的记录写入出站主题。或者,也可以定义一个没有出站目标的处理器应用程序。

在以下部分中,我们将深入了解 Spring Cloud Stream 与 Kafka Streams 集成的详细信息。

2.3. 编程模型

当使用 Kafka Streams binder 提供的编程模型时,可以使用高级 Streams DSL,也可以混合使用高级和低级 Processor-API。当混合使用高级和低级 API 时,通常通过调用 KStream 上的 transform 或 process API 方法来实现。

2.3.1. 函数式风格

从 Spring Cloud Stream 3.0.0 开始,Kafka Streams binder 允许应用程序使用 Java 8 中可用的函数式编程风格进行设计和开发。这意味着应用程序可以简洁地表示为 java.util.function.Function 或 java.util.function.Consumer 类型的 lambda 表达式。

让我们看一个非常基本的例子。

@SpringBootApplication

public class SimpleConsumerApplication {

@Bean

public java.util.function.Consumer<KStream<Object, String>> process() {

return input ->

input.foreach((key, value) -> {

System.out.println("Key: " + key + " Value: " + value);

});

}

}尽管简单,但这是一个完整的独立 Spring Boot 应用程序,它利用 Kafka Streams 进行流处理。这是一个没有出站绑定且只有一个入站绑定的消费者应用程序。该应用程序消费数据,并简单地将 KStream 键和值的信息记录到标准输出。该应用程序包含 SpringBootApplication 注解和一个标记为 Bean 的方法。bean 方法的类型是 java.util.function.Consumer,它被 KStream 参数化。然后,在实现中,我们返回一个 Consumer 对象,它本质上是一个 lambda 表达式。在 lambda 表达式内部,提供了处理数据的代码。

在此应用程序中,有一个类型为 KStream 的单一输入绑定。binder 为应用程序创建此绑定,名称为 process-in-0,即函数 bean 名称后跟一个短划线 (-) 和字面量 in,然后是另一个短划线,最后是参数的序数位置。您可以使用此绑定名称来设置其他属性,例如目标。例如,spring.cloud.stream.bindings.process-in-0.destination=my-topic。

| 如果未在绑定上设置目标属性,则会创建一个与绑定同名的主题(如果应用程序具有足够的权限),或者该主题预期已可用。 |

一旦构建为 uber-jar(例如,kstream-consumer-app.jar),您可以像下面这样运行上述示例。

如果应用程序选择使用 Spring 的 Component 注解定义函数式 bean,则 binder 也支持该模型。上述函数式 bean 可以改写如下。

@Component(name = "process")

public class SimpleConsumer implements java.util.function.Consumer<KStream<Object, String>> {

@Override

public void accept(KStream<Object, String> input) {

input.foreach((key, value) -> {

System.out.println("Key: " + key + " Value: " + value);

});

}

}java -jar kstream-consumer-app.jar --spring.cloud.stream.bindings.process-in-0.destination=my-topic这里是另一个示例,它是一个完整的处理器,既有输入绑定又有输出绑定。这是一个经典的词频统计示例,其中应用程序从主题接收数据,然后计算每个单词在滚动时间窗口中的出现次数。

@SpringBootApplication

public class WordCountProcessorApplication {

@Bean

public Function<KStream<Object, String>, KStream<?, WordCount>> process() {

return input -> input

.flatMapValues(value -> Arrays.asList(value.toLowerCase().split("\\W+")))

.map((key, value) -> new KeyValue<>(value, value))

.groupByKey(Serialized.with(Serdes.String(), Serdes.String()))

.windowedBy(TimeWindows.of(5000))

.count(Materialized.as("word-counts-state-store"))

.toStream()

.map((key, value) -> new KeyValue<>(key.key(), new WordCount(key.key(), value,

new Date(key.window().start()), new Date(key.window().end()))));

}

public static void main(String[] args) {

SpringApplication.run(WordCountProcessorApplication.class, args);

}

}这里又是一个完整的 Spring Boot 应用程序。与第一个应用程序的不同之处在于,bean 方法的类型是 java.util.function.Function。Function 的第一个参数化类型用于输入 KStream,第二个参数化类型用于输出。在方法体中,提供了一个类型为 Function 的 lambda 表达式,并作为实现,给出了实际的业务逻辑。类似于前面讨论的基于 Consumer 的应用程序,此处的输入绑定默认命名为 process-in-0。对于输出,绑定名称也自动设置为 process-out-0。

一旦构建为 uber-jar(例如,wordcount-processor.jar),您可以像下面这样运行上述示例。

java -jar wordcount-processor.jar --spring.cloud.stream.bindings.process-in-0.destination=words --spring.cloud.stream.bindings.process-out-0.destination=counts此应用程序将从 Kafka 主题 words 消费消息,并将计算结果发布到输出主题 counts。

Spring Cloud Stream 将确保传入和传出主题的消息都自动绑定为 KStream 对象。作为开发人员,您可以专注于代码的业务方面,即编写处理器中所需的逻辑。设置 Kafka Streams 基础设施所需的 Kafka Streams 特定配置由框架自动处理。

我们上面看到的两个示例都有一个单一的 KStream 输入绑定。在这两种情况下,绑定都从一个主题接收记录。如果您想将多个主题复用到单个 KStream 绑定中,您可以在下面提供逗号分隔的 Kafka 主题作为目标。

spring.cloud.stream.bindings.process-in-0.destination=topic-1,topic-2,topic-3

此外,如果您希望将主题与正则表达式匹配,您还可以提供主题模式作为目标。

spring.cloud.stream.bindings.process-in-0.destination=input.*

多个输入绑定

许多非平凡的 Kafka Streams 应用程序通常通过多个绑定从多个主题消费数据。例如,一个主题作为 Kstream 消费,另一个主题作为 KTable 或 GlobalKTable 消费。应用程序可能希望将数据作为表类型接收的原因有很多。考虑一种用例,其中底层主题通过数据库的变更数据捕获 (CDC) 机制填充,或者应用程序只关心用于下游处理的最新更新。如果应用程序指定需要将数据绑定为 KTable 或 GlobalKTable,则 Kafka Streams binder 将正确地将目标绑定到 KTable 或 GlobalKTable,并使其可用于应用程序操作。我们将看看 Kafka Streams binder 中处理多个输入绑定的几种不同场景。

Kafka Streams Binder 中的 BiFunction

这是一个我们有两个输入和一个输出的示例。在这种情况下,应用程序可以利用 java.util.function.BiFunction。

@Bean

public BiFunction<KStream<String, Long>, KTable<String, String>, KStream<String, Long>> process() {

return (userClicksStream, userRegionsTable) -> (userClicksStream

.leftJoin(userRegionsTable, (clicks, region) -> new RegionWithClicks(region == null ?

"UNKNOWN" : region, clicks),

Joined.with(Serdes.String(), Serdes.Long(), null))

.map((user, regionWithClicks) -> new KeyValue<>(regionWithClicks.getRegion(),

regionWithClicks.getClicks()))

.groupByKey(Grouped.with(Serdes.String(), Serdes.Long()))

.reduce(Long::sum)

.toStream());

}这里,基本主题与前面的示例相同,但我们有两个输入。Java 的 BiFunction 支持用于将输入绑定到所需的目标。binder 为输入生成的默认绑定名称分别是 process-in-0 和 process-in-1。默认输出绑定是 process-out-0。在此示例中,BiFunction 的第一个参数绑定为第一个输入的 KStream,第二个参数绑定为第二个输入的 KTable。

Kafka Streams Binder 中的 BiConsumer

如果存在两个输入但没有输出,在这种情况下,我们可以使用 java.util.function.BiConsumer,如下所示。

@Bean

public BiConsumer<KStream<String, Long>, KTable<String, String>> process() {

return (userClicksStream, userRegionsTable) -> {}

}超过两个输入

如果您的输入超过两个怎么办?在某些情况下,您需要两个以上的输入。在这种情况下,binder 允许您链接部分函数。在函数式编程术语中,这种技术通常称为柯里化。随着 Java 8 中添加的函数式编程支持,Java 现在允许您编写柯里化函数。Spring Cloud Stream Kafka Streams binder 可以利用此功能来启用多个输入绑定。

让我们看一个例子。

@Bean

public Function<KStream<Long, Order>,

Function<GlobalKTable<Long, Customer>,

Function<GlobalKTable<Long, Product>, KStream<Long, EnrichedOrder>>>> enrichOrder() {

return orders -> (

customers -> (

products -> (

orders.join(customers,

(orderId, order) -> order.getCustomerId(),

(order, customer) -> new CustomerOrder(customer, order))

.join(products,

(orderId, customerOrder) -> customerOrder

.productId(),

(customerOrder, product) -> {

EnrichedOrder enrichedOrder = new EnrichedOrder();

enrichedOrder.setProduct(product);

enrichedOrder.setCustomer(customerOrder.customer);

enrichedOrder.setOrder(customerOrder.order);

return enrichedOrder;

})

)

)

);

}让我们看看上面介绍的绑定模型的细节。在这个模型中,我们在入站有 3 个部分应用的函数。我们称它们为 f(x)、f(y) 和 f(z)。如果我们在真实数学函数的意义上展开这些函数,它将看起来像这样:f(x) → (fy) → f(z) → KStream<Long, EnrichedOrder>。x 变量代表 KStream<Long, Order>,y 变量代表 GlobalKTable<Long, Customer>,z 变量代表 GlobalKTable<Long, Product>。第一个函数 f(x) 具有应用程序的第一个输入绑定 (KStream<Long, Order>),其输出是函数 f(y)。函数 f(y) 具有应用程序的第二个输入绑定 (GlobalKTable<Long, Customer>),其输出是另一个函数 f(z)。函数 f(z) 的输入是应用程序的第三个输入 (GlobalKTable<Long, Product>),其输出是 KStream<Long, EnrichedOrder>,这是应用程序的最终输出绑定。来自三个部分函数的输入,它们分别是 KStream、GlobalKTable、GlobalKTable,在方法体中可供您用于实现作为 lambda 表达式一部分的业务逻辑。

输入绑定分别命名为 enrichOrder-in-0、enrichOrder-in-1 和 enrichOrder-in-2。输出绑定命名为 enrichOrder-out-0。

使用柯里化函数,您实际上可以拥有任意数量的输入。但是,请记住,如果输入数量过多,并且像上面 Java 中那样部分应用的函数过多,可能会导致代码难以阅读。因此,如果您的 Kafka Streams 应用程序需要超过合理数量的输入绑定,并且您想使用此函数模型,那么您可能需要重新考虑您的设计并适当地分解应用程序。

输出绑定

Kafka Streams binder 允许 KStream 或 KTable 类型作为输出绑定。在幕后,binder 使用 KStream 上的 to 方法将结果记录发送到输出主题。如果应用程序在函数中提供 KTable 作为输出,binder 仍然通过委托给 KStream 的 to 方法来使用此技术。

例如,以下两个函数都将起作用

@Bean

public Function<KStream<String, String>, KTable<String, String>> foo() {

return KStream::toTable;

};

}

@Bean

public Function<KTable<String, String>, KStream<String, String>> bar() {

return KTable::toStream;

}多个输出绑定

Kafka Streams 允许将出站数据写入多个主题。此功能在 Kafka Streams 中称为分支。当使用多个输出绑定时,您需要提供一个 KStream 数组 (KStream[]) 作为出站返回类型。

这是一个例子

@Bean

public Function<KStream<Object, String>, KStream<?, WordCount>[]> process() {

Predicate<Object, WordCount> isEnglish = (k, v) -> v.word.equals("english");

Predicate<Object, WordCount> isFrench = (k, v) -> v.word.equals("french");

Predicate<Object, WordCount> isSpanish = (k, v) -> v.word.equals("spanish");

return input -> {

final Map<String, KStream<Object, WordCount>> stringKStreamMap = input

.flatMapValues(value -> Arrays.asList(value.toLowerCase().split("\\W+")))

.groupBy((key, value) -> value)

.windowedBy(TimeWindows.of(Duration.ofSeconds(5)))

.count(Materialized.as("WordCounts-branch"))

.toStream()

.map((key, value) -> new KeyValue<>(null, new WordCount(key.key(), value,

new Date(key.window().start()), new Date(key.window().end()))))

.split()

.branch(isEnglish)

.branch(isFrench)

.branch(isSpanish)

.noDefaultBranch();

return stringKStreamMap.values().toArray(new KStream[0]);

};

}编程模型保持不变,但出站参数化类型为 KStream[]。对于上述函数,默认的输出绑定名称分别是 process-out-0、process-out-1、process-out-2。binder 生成三个输出绑定的原因是它检测到返回的 KStream 数组长度为三。请注意,在此示例中,我们提供了 noDefaultBranch();如果我们改为使用 defaultBranch(),那将需要一个额外的输出绑定,本质上返回一个长度为四的 KStream 数组。

Kafka Streams 函数式编程风格总结

总而言之,下表显示了函数式范式中可以使用的各种选项。

| 输入数量 | 输出数量 | 要使用的组件 |

|---|---|---|

1 |

0 |

java.util.function.Consumer |

2 |

0 |

java.util.function.BiConsumer |

1 |

1..n |

java.util.function.Function |

2 |

1..n |

java.util.function.BiFunction |

>= 3 |

0..n |

使用柯里化函数 |

-

在此表中,如果输出超过一个,则类型简单地变为

KStream[]。

Kafka Streams binder 中的函数组合

Kafka Streams binder 支持线性拓扑的最小形式的函数组合。使用 Java 函数式 API 支持,您可以编写多个函数,然后使用 andThen 方法自行组合它们。例如,假设您有以下两个函数。

@Bean

public Function<KStream<String, String>, KStream<String, String>> foo() {

return input -> input.peek((s, s2) -> {});

}

@Bean

public Function<KStream<String, String>, KStream<String, Long>> bar() {

return input -> input.peek((s, s2) -> {});

}即使没有 binder 中的函数组合支持,您也可以如下组合这两个函数。

@Bean

pubic Funcion<KStream<String, String>, KStream<String, Long>> composed() {

foo().andThen(bar());

}然后您可以提供 spring.cloud.stream.function.definition=foo;bar;composed 形式的定义。有了 binder 中的函数组合支持,您就不需要编写第三个进行显式函数组合的函数。

您可以简单地这样做

spring.cloud.stream.function.definition=foo|bar您甚至可以这样做

spring.cloud.stream.function.definition=foo|bar;foo;bar在此示例中,组合函数的默认绑定名称变为 foobar-in-0 和 foobar-out-0。

Kafka Streams bincer 中函数组合的限制

当您拥有 java.util.function.Function bean 时,它可以与另一个函数或多个函数组合。相同的函数 bean 也可以与 java.util.function.Consumer 组合。在这种情况下,消费者是最后一个组合的组件。一个函数可以与多个函数组合,然后以 java.util.function.Consumer bean 结尾。

当组合类型为 java.util.function.BiFunction 的 bean 时,BiFunction 必须是定义中的第一个函数。组合实体必须是 java.util.function.Function 或 java.util.function.Consumer 类型。换句话说,您不能接受一个 BiFunction bean,然后与另一个 BiFunction 组合。

您不能与 BiConsumer 类型或 Consumer 是第一个组件的定义进行组合。您也不能与输出为数组(用于分支的 KStream[])的函数进行组合,除非这是定义中的最后一个组件。

函数定义中的第一个 Function 或 BiFunction 也可以使用柯里化形式。例如,以下是可能的。

@Bean

public Function<KStream<String, String>, Function<KTable<String, String>, KStream<String, String>>> curriedFoo() {

return a -> b ->

a.join(b, (value1, value2) -> value1 + value2);

}

@Bean

public Function<KStream<String, String>, KStream<String, String>> bar() {

return input -> input.mapValues(value -> value + "From-anotherFooFunc");

}函数定义可以是 curriedFoo|bar。在幕后,binder 将为柯里化函数创建两个输入绑定,并根据定义中的最终函数创建一个输出绑定。在这种情况下,默认输入绑定将是 curriedFoobar-in-0 和 curriedFoobar-in-1。此示例的默认输出绑定将是 curriedFoobar-out-0。

函数组合中使用 KTable 作为输出的特别说明

假设您有两个函数。

@Bean

public Function<KStream<String, String>, KTable<String, String>> foo() {

return KStream::toTable;

};

}

@Bean

public Function<KTable<String, String>, KStream<String, String>> bar() {

return KTable::toStream;

}您可以将它们组合为 foo|bar,但请记住,第二个函数(本例中的 bar)必须具有 KTable 作为输入,因为第一个函数(foo)具有 KTable 作为输出。

2.3.2. 命令式编程模型。

从 binder 的 3.1.0 版本开始,我们建议对基于 Kafka Streams binder 的应用程序使用上面描述的函数式编程模型。从 Spring Cloud Stream 的 3.1.0 版本开始,对 StreamListener 的支持已弃用。下面,我们将提供一些关于基于 StreamListener 的 Kafka Streams 处理器的详细信息作为参考。

以下是使用 StreamListener 的词频统计示例的等效代码。

@SpringBootApplication

@EnableBinding(KafkaStreamsProcessor.class)

public class WordCountProcessorApplication {

@StreamListener("input")

@SendTo("output")

public KStream<?, WordCount> process(KStream<?, String> input) {

return input

.flatMapValues(value -> Arrays.asList(value.toLowerCase().split("\\W+")))

.groupBy((key, value) -> value)

.windowedBy(TimeWindows.of(5000))

.count(Materialized.as("WordCounts-multi"))

.toStream()

.map((key, value) -> new KeyValue<>(null, new WordCount(key.key(), value, new Date(key.window().start()), new Date(key.window().end()))));

}

public static void main(String[] args) {

SpringApplication.run(WordCountProcessorApplication.class, args);

}如您所见,这有点冗长,因为您需要提供 EnableBinding 和其他额外的注解,如 StreamListener 和 SendTo 才能使其成为一个完整的应用程序。EnableBinding 是您指定包含绑定的绑定接口的地方。在此示例中,我们使用包含以下契约的库存 KafkaStreamsProcessor 绑定接口。

public interface KafkaStreamsProcessor {

@Input("input")

KStream<?, ?> input();

@Output("output")

KStream<?, ?> output();

}Binder 将为输入的 KStream 和输出的 KStream 创建绑定,因为您正在使用包含这些声明的绑定接口。

除了函数式编程模型中提供的明显差异外,这里需要特别提到的一点是,绑定名称是您在绑定接口中指定的名称。例如,在上述应用程序中,由于我们使用的是 KafkaStreamsProcessor,因此绑定名称是 input 和 output。绑定属性需要使用这些名称。例如 spring.cloud.stream.bindings.input.destination、spring.cloud.stream.bindings.output.destination 等。请记住,这与函数式编程模型有着根本区别,因为在函数式编程模型中,binder 为应用程序生成绑定名称。这是因为应用程序在不使用 EnableBinding 的函数式模型中不提供任何绑定接口。

这是另一个有两个输入的 sink 示例。

@EnableBinding(KStreamKTableBinding.class)

.....

.....

@StreamListener

public void process(@Input("inputStream") KStream<String, PlayEvent> playEvents,

@Input("inputTable") KTable<Long, Song> songTable) {

....

....

}

interface KStreamKTableBinding {

@Input("inputStream")

KStream<?, ?> inputStream();

@Input("inputTable")

KTable<?, ?> inputTable();

}以下是上面看到的基于 BiFunction 的处理器的 StreamListener 等效项。

@EnableBinding(KStreamKTableBinding.class)

....

....

@StreamListener

@SendTo("output")

public KStream<String, Long> process(@Input("input") KStream<String, Long> userClicksStream,

@Input("inputTable") KTable<String, String> userRegionsTable) {

....

....

}

interface KStreamKTableBinding extends KafkaStreamsProcessor {

@Input("inputX")

KTable<?, ?> inputTable();

}最后,这是具有三个输入和柯里化函数的应用程序的 StreamListener 等效项。

@EnableBinding(CustomGlobalKTableProcessor.class)

...

...

@StreamListener

@SendTo("output")

public KStream<Long, EnrichedOrder> process(

@Input("input-1") KStream<Long, Order> ordersStream,

@Input("input-2") GlobalKTable<Long, Customer> customers,

@Input("input-3") GlobalKTable<Long, Product> products) {

KStream<Long, CustomerOrder> customerOrdersStream = ordersStream.join(

customers, (orderId, order) -> order.getCustomerId(),

(order, customer) -> new CustomerOrder(customer, order));

return customerOrdersStream.join(products,

(orderId, customerOrder) -> customerOrder.productId(),

(customerOrder, product) -> {

EnrichedOrder enrichedOrder = new EnrichedOrder();

enrichedOrder.setProduct(product);

enrichedOrder.setCustomer(customerOrder.customer);

enrichedOrder.setOrder(customerOrder.order);

return enrichedOrder;

});

}

interface CustomGlobalKTableProcessor {

@Input("input-1")

KStream<?, ?> input1();

@Input("input-2")

GlobalKTable<?, ?> input2();

@Input("input-3")

GlobalKTable<?, ?> input3();

@Output("output")

KStream<?, ?> output();

}您可能会注意到,上面两个示例更加冗长,因为除了提供 EnableBinding 之外,您还需要编写自己的自定义绑定接口。使用函数式模型,您可以避免所有这些繁琐的细节。

在继续研究 Kafka Streams binder 提供的通用编程模型之前,这里是多个输出绑定的 StreamListener 版本。

EnableBinding(KStreamProcessorWithBranches.class)

public static class WordCountProcessorApplication {

@Autowired

private TimeWindows timeWindows;

@StreamListener("input")

@SendTo({"output1","output2","output3"})

public KStream<?, WordCount>[] process(KStream<Object, String> input) {

Predicate<Object, WordCount> isEnglish = (k, v) -> v.word.equals("english");

Predicate<Object, WordCount> isFrench = (k, v) -> v.word.equals("french");

Predicate<Object, WordCount> isSpanish = (k, v) -> v.word.equals("spanish");

return input

.flatMapValues(value -> Arrays.asList(value.toLowerCase().split("\\W+")))

.groupBy((key, value) -> value)

.windowedBy(timeWindows)

.count(Materialized.as("WordCounts-1"))

.toStream()

.map((key, value) -> new KeyValue<>(null, new WordCount(key.key(), value, new Date(key.window().start()), new Date(key.window().end()))))

.branch(isEnglish, isFrench, isSpanish);

}

interface KStreamProcessorWithBranches {

@Input("input")

KStream<?, ?> input();

@Output("output1")

KStream<?, ?> output1();

@Output("output2")

KStream<?, ?> output2();

@Output("output3")

KStream<?, ?> output3();

}

}总结一下,我们回顾了使用 Kafka Streams binder 时的各种编程模型选择。

binder 为输入的 KStream、KTable 和 GlobalKTable 提供绑定功能。KTable 和 GlobalKTable 绑定仅在输入端可用。Binder 支持 KStream 的输入和输出绑定。

Kafka Streams binder 编程模型的优点是,binder 为您提供了选择完全函数式编程模型或使用基于 StreamListener 的命令式方法的灵活性。

2.4. 编程模型的辅助功能

2.4.1. 单个应用程序中的多个 Kafka Streams 处理器

Binder 允许在一个 Spring Cloud Stream 应用程序中包含多个 Kafka Streams 处理器。您可以拥有如下应用程序。

@Bean

public java.util.function.Function<KStream<Object, String>, KStream<Object, String>> process() {

...

}

@Bean

public java.util.function.Consumer<KStream<Object, String>> anotherProcess() {

...

}

@Bean

public java.util.function.BiFunction<KStream<Object, String>, KTable<Integer, String>, KStream<Object, String>> yetAnotherProcess() {

...

}在这种情况下,binder 将创建 3 个独立的 Kafka Streams 对象,它们具有不同的应用程序 ID(下面将详细介绍)。但是,如果应用程序中有多个处理器,您必须告诉 Spring Cloud Stream 需要激活哪些函数。以下是激活函数的方法。

spring.cloud.stream.function.definition: process;anotherProcess;yetAnotherProcess

如果您希望某些功能不立即激活,可以将其从列表中删除。

当您在同一个应用程序中拥有一个 Kafka Streams 处理器和通过不同 binder 处理的其他类型的 Function bean 时,这也是如此(例如,一个基于常规 Kafka 消息通道 binder 的函数 bean)。

2.4.2. Kafka Streams 应用程序 ID

应用程序 ID 是 Kafka Streams 应用程序必须提供的属性。Spring Cloud Stream Kafka Streams binder 允许您以多种方式配置此应用程序 ID。

如果应用程序中只有一个处理器或 StreamListener,则可以使用以下属性在 binder 级别设置此项

spring.cloud.stream.kafka.streams.binder.applicationId.

为了方便起见,如果您只有一个处理器,您还可以使用 spring.application.name 作为属性来委托应用程序 ID。

如果应用程序中有多个 Kafka Streams 处理器,则需要为每个处理器设置应用程序 ID。在函数式模型中,您可以将其作为属性附加到每个函数。

例如,假设您有以下函数。

@Bean

public java.util.function.Consumer<KStream<Object, String>> process() {

...

}和

@Bean

public java.util.function.Consumer<KStream<Object, String>> anotherProcess() {

...

}然后,您可以使用以下 binder 级别属性为每个函数设置应用程序 ID。

spring.cloud.stream.kafka.streams.binder.functions.process.applicationId

和

spring.cloud.stream.kafka.streams.binder.functions.anotherProcess.applicationId

对于 StreamListener,您需要在处理器的第一个输入绑定上设置此项。

例如,假设您有以下两个基于 StreamListener 的处理器。

@StreamListener

@SendTo("output")

public KStream<String, String> process(@Input("input") <KStream<Object, String>> input) {

...

}

@StreamListener

@SendTo("anotherOutput")

public KStream<String, String> anotherProcess(@Input("anotherInput") <KStream<Object, String>> input) {

...

}然后,您必须使用以下绑定属性设置此应用程序 ID。

spring.cloud.stream.kafka.streams.bindings.input.consumer.applicationId

和

spring.cloud.stream.kafka.streams.bindings.anotherInput.consumer.applicationId

对于基于函数式模型,这种在绑定级别设置应用程序 ID 的方法也适用。但是,如果您使用函数式模型,如上所述在 binder 级别为每个函数设置应用程序 ID 会更容易。

对于生产部署,强烈建议通过配置显式指定应用程序 ID。如果您正在自动扩展应用程序,则这一点尤为关键,在这种情况下,您需要确保部署的每个实例都具有相同的应用程序 ID。

如果应用程序未提供应用程序 ID,则 binder 将为您自动生成一个静态应用程序 ID。这在开发场景中很方便,因为它避免了显式提供应用程序 ID 的需要。以这种方式生成的应用程序 ID 在应用程序重启后将是静态的。在函数式模型中,生成的应用程序 ID 将是函数 bean 名称后跟字面量 applicationID,例如,如果 process 是函数 bean 名称,则为 process-applicationID。对于 StreamListener,生成的应用程序 ID 将使用包含类名称后跟方法名称,然后是字面量 applicationId,而不是使用函数 bean 名称。

设置应用程序 ID 总结

-

默认情况下,binder 将为每个函数或

StreamListener方法自动生成应用程序 ID。 -

如果您有一个处理器,则可以使用

spring.kafka.streams.applicationId、spring.application.name或spring.cloud.stream.kafka.streams.binder.applicationId。 -

如果您有多个处理器,则可以使用属性

spring.cloud.stream.kafka.streams.binder.functions.<function-name>.applicationId为每个函数设置应用程序 ID。对于StreamListener,可以使用spring.cloud.stream.kafka.streams.bindings.input.applicationId完成此操作,假设输入绑定名称为input。

2.4.3. 使用函数式风格覆盖 binder 生成的默认绑定名称

默认情况下,当使用函数式样式时,binder 使用上述策略生成绑定名称,即 <function-bean-name>-<in>|<out>-[0..n],例如 process-in-0、process-out-0 等。如果您想覆盖这些绑定名称,可以通过指定以下属性来完成。

spring.cloud.stream.function.bindings.<default binding name>。默认绑定名称是 binder 生成的原始绑定名称。

例如,假设您有这个函数。

@Bean

public BiFunction<KStream<String, Long>, KTable<String, String>, KStream<String, Long>> process() {

...

}Binder 将生成名称为 process-in-0、process-in-1 和 process-out-0 的绑定。现在,如果您想将它们完全更改为其他名称,可能是更具领域特定性的绑定名称,那么您可以如下操作。

spring.cloud.stream.function.bindings.process-in-0=users

spring.cloud.stream.function.bindings.process-in-0=regions

和

spring.cloud.stream.function.bindings.process-out-0=clicks

之后,您必须将所有绑定级别属性设置到这些新的绑定名称上。

请记住,对于上面描述的函数式编程模型,在大多数情况下,遵守默认绑定名称是有意义的。您可能仍然想要进行此覆盖的唯一原因是当您有大量配置属性并且希望将绑定映射到更领域友好的名称时。

2.4.4. 设置引导服务器配置

运行 Kafka Streams 应用程序时,必须提供 Kafka broker 服务器信息。如果您不提供此信息,binder 期望您在默认的 localhost:9092 上运行 broker。如果不是这种情况,则需要覆盖它。有几种方法可以做到这一点。

-

使用 boot 属性 -

spring.kafka.bootstrapServers -

Binder 级别属性 -

spring.cloud.stream.kafka.streams.binder.brokers

对于 binder 级别属性,无论您是使用通过常规 Kafka binder 提供的 broker 属性 - spring.cloud.stream.kafka.binder.brokers 都没有关系。Kafka Streams binder 将首先检查是否设置了 Kafka Streams binder 特定 broker 属性(spring.cloud.stream.kafka.streams.binder.brokers),如果未找到,则查找 spring.cloud.stream.kafka.binder.brokers。

2.5. 记录序列化和反序列化

Kafka Streams binder 允许您以两种方式序列化和反序列化记录。一种是 Kafka 提供的原生序列化和反序列化功能,另一种是 Spring Cloud Stream 框架的消息转换功能。让我们看一些细节。

2.5.1. 入站反序列化

键始终使用原生 Serdes 反序列化。

对于值,默认情况下,入站反序列化由 Kafka 原生执行。请注意,这是 Kafka Streams binder 以前版本默认行为的重大更改,以前的反序列化是由框架完成的。

Kafka Streams binder 将尝试通过查看 java.util.function.Function|Consumer 或 StreamListener 的类型签名来推断匹配的 Serde 类型。以下是它匹配 Serdes 的顺序。

-

如果应用程序提供了

Serde类型的 bean,并且返回类型使用传入键或值的实际类型参数化,则它将使用该Serde进行入站反序列化。例如,如果应用程序中存在以下内容,则 binder 会检测到KStream的传入值类型与Serdebean 参数化的类型匹配。它将使用该类型进行入站反序列化。

@Bean

public Serde<Foo> customSerde() {

...

}

@Bean

public Function<KStream<String, Foo>, KStream<String, Foo>> process() {

}-

接下来,它查看类型并查看它们是否是 Kafka Streams 公开的类型之一。如果是,则使用它们。以下是 binder 将尝试从 Kafka Streams 匹配的 Serde 类型。

Integer, Long, Short, Double, Float, byte[], UUID and String.

-

如果 Kafka Streams 提供的 Serde 都不匹配这些类型,那么它将使用 Spring Kafka 提供的 JsonSerde。在这种情况下,binder 假定这些类型是 JSON 友好的。这在您有多个值对象作为输入时很有用,因为 binder 将在内部将它们推断为正确的 Java 类型。但在回退到

JsonSerde之前,binder 会检查 Kafka Streams 配置中设置的默认Serde`s,以查看它是否是可以与传入 KStream 的类型匹配的 `Serde。

如果上述策略均未奏效,则应用程序必须通过配置提供 Serde。这可以通过两种方式配置 - 绑定或默认。

首先,binder 将检查是否在绑定级别提供了 Serde。例如,如果您有以下处理器,

@Bean

public BiFunction<KStream<CustomKey, AvroIn1>, KTable<CustomKey, AvroIn2>, KStream<CustomKey, AvroOutput>> process() {...}然后,您可以使用以下方式提供绑定级别 Serde

spring.cloud.stream.kafka.streams.bindings.process-in-0.consumer.keySerde=CustomKeySerde

spring.cloud.stream.kafka.streams.bindings.process-in-0.consumer.valueSerde=io.confluent.kafka.streams.serdes.avro.SpecificAvroSerde

spring.cloud.stream.kafka.streams.bindings.process-in-1.consumer.keySerde=CustomKeySerde

spring.cloud.stream.kafka.streams.bindings.process-in-1.consumer.valueSerde=io.confluent.kafka.streams.serdes.avro.SpecificAvroSerde如果您如上所述为每个输入绑定提供 Serde,那么这将具有更高的优先级,并且 binder 将避免任何 Serde 推理。 |

如果您希望将默认的键/值 Serdes 用于入站反序列化,则可以在 binder 级别进行设置。

spring.cloud.stream.kafka.streams.binder.configuration.default.key.serde

spring.cloud.stream.kafka.streams.binder.configuration.default.value.serde如果您不希望使用 Kafka 提供的原生解码,则可以依赖 Spring Cloud Stream 提供的消息转换功能。由于原生解码是默认设置,为了让 Spring Cloud Stream 反序列化入站值对象,您需要显式禁用原生解码。

例如,如果您拥有与上面相同的 BiFunction 处理器,那么 spring.cloud.stream.bindings.process-in-0.consumer.nativeDecoding: false。您需要单独禁用所有输入的原生解码。否则,对于那些您未禁用的输入,原生解码仍将适用。

默认情况下,Spring Cloud Stream 将使用 application/json 作为内容类型并使用适当的 json 消息转换器。您可以通过使用以下属性和适当的 MessageConverter bean 来使用自定义消息转换器。

spring.cloud.stream.bindings.process-in-0.contentType2.5.2. 出站序列化

出站序列化与上述入站反序列化遵循相同的规则。与入站反序列化一样,Spring Cloud Stream 以前版本的一个主要变化是出站序列化由 Kafka 原生处理。在 binder 的 3.0 版本之前,这是由框架本身完成的。

出站键始终由 Kafka 使用 binder 推断的匹配 Serde 进行序列化。如果它无法推断键的类型,则需要通过配置指定。

值 Serdes 使用与入站反序列化相同的规则进行推断。首先,它匹配以查看出站类型是否来自应用程序中提供的 bean。如果不是,它会检查是否与 Kafka 公开的 Serde 匹配,例如 - Integer、Long、Short、Double、Float、byte[]、UUID 和 String。如果不起作用,它会回退到 Spring Kafka 项目提供的 JsonSerde,但首先会查看默认的 Serde 配置以查看是否有匹配项。请记住,所有这些对应用程序都是透明的。如果这些都不起作用,则用户必须通过配置提供要使用的 Serde。

假设您正在使用与上面相同的 BiFunction 处理器。然后,您可以按如下方式配置出站键/值 Serdes。

spring.cloud.stream.kafka.streams.bindings.process-out-0.producer.keySerde=CustomKeySerde

spring.cloud.stream.kafka.streams.bindings.process-out-0.producer.valueSerde=io.confluent.kafka.streams.serdes.avro.SpecificAvroSerde如果 Serde 推理失败,并且没有提供绑定级别的 Serdes,那么 binder 将回退到 JsonSerde,但会查看默认的 Serdes 以进行匹配。

默认 Serdes 的配置方式与上面在反序列化部分描述的方式相同。

spring.cloud.stream.kafka.streams.binder.configuration.default.key.serde spring.cloud.stream.kafka.streams.binder.configuration.default.value.serde

如果您的应用程序使用分支功能并具有多个输出绑定,则需要为每个绑定配置这些功能。同样,如果 binder 能够推断 Serde 类型,则无需进行此配置。

如果您不希望使用 Kafka 提供的原生编码,而是希望使用框架提供的消息转换,那么您需要显式禁用原生编码,因为原生编码是默认设置。例如,如果您有与上面相同的 BiFunction 处理器,那么 spring.cloud.stream.bindings.process-out-0.producer.nativeEncoding: false。在分支的情况下,您需要单独禁用所有输出的原生编码。否则,对于那些您未禁用的输出,原生编码仍将适用。

当由 Spring Cloud Stream 完成转换时,默认情况下,它将使用 application/json 作为内容类型并使用适当的 json 消息转换器。您可以通过使用以下属性和相应的 MessageConverter bean 来使用自定义消息转换器。

spring.cloud.stream.bindings.process-out-0.contentType当禁用原生编码/解码时,binder 不会像原生 Serdes 那样进行任何推断。应用程序需要显式提供所有配置选项。因此,建议在编写 Spring Cloud Stream Kafka Streams 应用程序时,通常坚持使用默认的反序列化选项并坚持使用 Kafka Streams 提供的原生反序列化。您必须使用框架提供的消息转换能力的唯一场景是当您的上游生产者使用特定的序列化策略时。在这种情况下,您希望使用匹配的反序列化策略,因为原生机制可能会失败。当依赖默认的 Serde 机制时,应用程序必须确保 binder 能够正确地将入站和出站映射到适当的 Serde,否则可能会失败。

值得一提的是,上面概述的数据解/序列化方法仅适用于处理器的边缘,即入站和出站。您的业务逻辑可能仍需要调用需要显式 Serde 对象的 Kafka Streams API。这些仍然是应用程序的责任,必须由开发人员相应地处理。

2.6. 错误处理

Apache Kafka Streams 提供了原生处理反序列化错误的异常处理能力。有关此支持的详细信息,请参阅 此 文档。Apache Kafka Streams 开箱即用地提供了两种反序列化异常处理器 - LogAndContinueExceptionHandler 和 LogAndFailExceptionHandler。顾名思义,前者将记录错误并继续处理下一个记录,后者将记录错误并失败。LogAndFailExceptionHandler 是默认的反序列化异常处理器。

2.6.1. 处理 Binder 中的反序列化异常

Kafka Streams binder 允许使用以下属性指定上述反序列化异常处理器。

spring.cloud.stream.kafka.streams.binder.deserializationExceptionHandler: logAndContinue或

spring.cloud.stream.kafka.streams.binder.deserializationExceptionHandler: logAndFail除了上述两种反序列化异常处理器外,binder 还提供了第三种,用于将错误记录(毒丸)发送到 DLQ(死信队列)主题。以下是启用此 DLQ 异常处理器的方法。

spring.cloud.stream.kafka.streams.binder.deserializationExceptionHandler: sendToDlq设置上述属性后,所有反序列化错误的记录将自动发送到 DLQ 主题。

您可以如下设置发布 DLQ 消息的主题名称。

您可以提供 DlqDestinationResolver 的实现,它是一个函数式接口。DlqDestinationResolver 将 ConsumerRecord 和异常作为输入,然后允许指定主题名称作为输出。通过访问 Kafka ConsumerRecord,可以在 BiFunction 的实现中检查头部记录。

以下是提供 DlqDestinationResolver 实现的示例。

@Bean

public DlqDestinationResolver dlqDestinationResolver() {

return (rec, ex) -> {

if (rec.topic().equals("word1")) {

return "topic1-dlq";

}

else {

return "topic2-dlq";

}

};

}在提供 DlqDestinationResolver 的实现时,需要记住一件重要的事情,那就是绑定器中的 provisioner 不会自动为应用程序创建主题。这是因为绑定器无法推断出实现可能发送到的所有 DLQ 主题的名称。因此,如果您使用此策略提供 DLQ 名称,应用程序有责任确保这些主题事先已创建。

如果应用程序中存在 DlqDestinationResolver bean,则它具有更高的优先级。如果您不想遵循此方法,而是希望通过配置提供静态 DLQ 名称,则可以设置以下属性。

spring.cloud.stream.kafka.streams.bindings.process-in-0.consumer.dlqName: custom-dlq (Change the binding name accordingly)如果设置了此项,则错误记录将发送到主题 custom-dlq。如果应用程序未使用上述任何一种策略,则它将创建一个名为 error.<input-topic-name>.<application-id> 的 DLQ 主题。例如,如果您的绑定的目标主题是 inputTopic,应用程序 ID 是 process-applicationId,则默认 DLQ 主题是 error.inputTopic.process-applicationId。如果您打算启用 DLQ,始终建议为每个输入绑定显式创建一个 DLQ 主题。

2.6.2. 每个输入消费者绑定的 DLQ

属性 spring.cloud.stream.kafka.streams.binder.deserializationExceptionHandler 适用于整个应用程序。这意味着如果同一应用程序中有多个函数或 StreamListener 方法,此属性将应用于所有这些方法。但是,如果一个处理器中有多个处理器或多个输入绑定,则可以使用 binder 为每个输入消费者绑定提供的更细粒度的 DLQ 控制。

如果您有以下处理器,

@Bean

public BiFunction<KStream<String, Long>, KTable<String, String>, KStream<String, Long>> process() {

...

}并且您只想在第一个输入绑定上启用 DLQ,在第二个绑定上跳过并继续,那么您可以在消费者上按如下操作。

spring.cloud.stream.kafka.streams.bindings.process-in-0.consumer.deserializationExceptionHandler: sendToDlq spring.cloud.stream.kafka.streams.bindings.process-in-1.consumer.deserializationExceptionHandler: skipAndContinue

以这种方式设置反序列化异常处理器比在 binder 级别设置具有更高的优先级。

2.6.3. DLQ 分区

默认情况下,记录发布到死信主题时使用与原始记录相同的分区。这意味着死信主题必须至少有与原始记录相同数量的分区。

要更改此行为,请将 DlqPartitionFunction 实现添加为应用程序上下文中的 @Bean。只能存在一个这样的 bean。该函数提供消费者组(在大多数情况下与应用程序 ID 相同)、失败的 ConsumerRecord 和异常。例如,如果您总是希望路由到分区 0,您可以使用

@Bean

public DlqPartitionFunction partitionFunction() {

return (group, record, ex) -> 0;

}如果您将消费者绑定的 dlqPartitions 属性设置为 1(并且绑定的 minPartitionCount 等于 1),则无需提供 DlqPartitionFunction;框架将始终使用分区 0。如果您将消费者绑定的 dlqPartitions 属性设置为大于 1 的值(或绑定的 minPartitionCount 大于 1),则您必须提供一个 DlqPartitionFunction bean,即使分区计数与原始主题相同。 |

在使用 Kafka Streams binder 中的异常处理功能时,需要注意几点。

-

属性

spring.cloud.stream.kafka.streams.binder.deserializationExceptionHandler适用于整个应用程序。这意味着如果同一应用程序中有多个函数或StreamListener方法,此属性将应用于所有这些方法。 -

反序列化的异常处理与原生反序列化和框架提供的消息转换一致工作。

2.6.4. 处理 Binder 中的生产异常

与上述反序列化异常处理程序的支持不同,binder 不提供用于处理生产异常的此类一流机制。但是,您仍然可以使用 StreamsBuilderFactoryBean 定制器来配置生产异常处理程序,您可以在下面的后续部分中找到更多详细信息。

2.7. 重试关键业务逻辑

在某些情况下,您可能希望重试应用程序中对业务逻辑至关重要的部分。这可能是对关系数据库的外部调用,或从 Kafka Streams 处理器调用 REST 端点。这些调用可能由于各种原因(例如网络问题或远程服务不可用)而失败。通常,如果可以再次尝试,这些故障可能会自行解决。默认情况下,Kafka Streams binder 会为所有输入绑定创建 RetryTemplate bean。

如果函数具有以下签名,

@Bean

public java.util.function.Consumer<KStream<Object, String>> process()并且使用默认绑定名称,RetryTemplate 将注册为 process-in-0-RetryTemplate。这遵循绑定名称(process-in-0)后跟字面量 -RetryTemplate 的约定。在多个输入绑定的情况下,每个绑定将有一个单独的 RetryTemplate bean 可用。如果应用程序中有一个自定义 RetryTemplate bean,并通过 spring.cloud.stream.bindings.<binding-name>.consumer.retryTemplateName 提供,那么它将优先于任何输入绑定级别的重试模板配置属性。

一旦将绑定中的 RetryTemplate 注入到应用程序中,它就可以用于重试应用程序的任何关键部分。这是一个示例

@Bean

public java.util.function.Consumer<KStream<Object, String>> process(@Lazy @Qualifier("process-in-0-RetryTemplate") RetryTemplate retryTemplate) {

return input -> input

.process(() -> new Processor<Object, String>() {

@Override

public void init(ProcessorContext processorContext) {

}

@Override

public void process(Object o, String s) {

retryTemplate.execute(context -> {

//Critical business logic goes here.

});

}

@Override

public void close() {

}

});

}或者您可以使用自定义 RetryTemplate 如下。

@EnableAutoConfiguration

public static class CustomRetryTemplateApp {

@Bean

@StreamRetryTemplate

RetryTemplate fooRetryTemplate() {

RetryTemplate retryTemplate = new RetryTemplate();

RetryPolicy retryPolicy = new SimpleRetryPolicy(4);

FixedBackOffPolicy backOffPolicy = new FixedBackOffPolicy();

backOffPolicy.setBackOffPeriod(1);

retryTemplate.setBackOffPolicy(backOffPolicy);

retryTemplate.setRetryPolicy(retryPolicy);

return retryTemplate;

}

@Bean

public java.util.function.Consumer<KStream<Object, String>> process() {

return input -> input

.process(() -> new Processor<Object, String>() {

@Override

public void init(ProcessorContext processorContext) {

}

@Override

public void process(Object o, String s) {

fooRetryTemplate().execute(context -> {

//Critical business logic goes here.

});

}

@Override

public void close() {

}

});

}

}请注意,当重试次数耗尽时,默认情况下会抛出最后一个异常,导致处理器终止。如果您希望处理异常并继续处理,可以将 RecoveryCallback 添加到 execute 方法中:这是一个示例。

retryTemplate.execute(context -> {

//Critical business logic goes here.

}, context -> {

//Recovery logic goes here.

return null;

));有关 RetryTemplate、重试策略、回退策略等的更多信息,请参阅 Spring Retry 项目。

2.8. 状态存储

当使用高级 DSL 并进行触发状态存储的适当调用时,Kafka Streams 会自动创建状态存储。

如果您想将传入的 KTable 绑定具体化为命名状态存储,那么您可以使用以下策略。

假设您有以下函数。

@Bean

public BiFunction<KStream<String, Long>, KTable<String, String>, KStream<String, Long>> process() {

...

}然后通过设置以下属性,传入的 KTable 数据将被具体化到命名状态存储中。

spring.cloud.stream.kafka.streams.bindings.process-in-1.consumer.materializedAs: incoming-store您可以在应用程序中将自定义状态存储定义为 bean,这些状态存储将被 binder 检测并添加到 Kafka Streams 构建器中。特别是当使用处理器 API 时,您需要手动注册一个状态存储。为此,您可以在应用程序中将 StateStore 创建为一个 bean。以下是定义此类 bean 的示例。

@Bean

public StoreBuilder myStore() {

return Stores.keyValueStoreBuilder(

Stores.persistentKeyValueStore("my-store"), Serdes.Long(),

Serdes.Long());

}

@Bean

public StoreBuilder otherStore() {

return Stores.windowStoreBuilder(

Stores.persistentWindowStore("other-store",

1L, 3, 3L, false), Serdes.Long(),

Serdes.Long());

}这些状态存储可以由应用程序直接访问。

在引导期间,上述 bean 将由 binder 处理并传递给 Streams 构建器对象。

访问状态存储

Processor<Object, Product>() {

WindowStore<Object, String> state;

@Override

public void init(ProcessorContext processorContext) {

state = (WindowStore)processorContext.getStateStore("mystate");

}

...

}在注册全局状态存储时,这将不起作用。为了注册全局状态存储,请参阅下面关于自定义 StreamsBuilderFactoryBean 的部分。

2.9. 交互式查询

Kafka Streams binder API 公开了一个名为 InteractiveQueryService 的类,用于交互式查询状态存储。您可以在应用程序中将其作为 Spring bean 访问。从应用程序访问此 bean 的简单方法是自动注入此 bean。

@Autowired

private InteractiveQueryService interactiveQueryService;一旦您访问到这个 bean,就可以查询您感兴趣的特定状态存储。请看下面。

ReadOnlyKeyValueStore<Object, Object> keyValueStore =

interactiveQueryService.getQueryableStoreType("my-store", QueryableStoreTypes.keyValueStore());在启动期间,上述检索存储的方法调用可能会失败。例如,它可能仍在初始化状态存储。在这种情况下,重试此操作将很有用。Kafka Streams binder 提供了一个简单的重试机制来适应这种情况。

以下是可用于控制此重试的两个属性。

-

spring.cloud.stream.kafka.streams.binder.stateStoreRetry.maxAttempts - 默认值为

1。 -

spring.cloud.stream.kafka.streams.binder.stateStoreRetry.backOffInterval - 默认值为

1000毫秒。

如果有多个 Kafka Streams 应用程序实例正在运行,那么在交互式查询它们之前,您需要识别哪个应用程序实例托管您正在查询的特定键。InteractiveQueryService API 提供了识别主机信息的方法。

为了使此功能正常工作,您必须按如下方式配置属性 application.server

spring.cloud.stream.kafka.streams.binder.configuration.application.server: <server>:<port>以下是一些代码片段

org.apache.kafka.streams.state.HostInfo hostInfo = interactiveQueryService.getHostInfo("store-name",

key, keySerializer);

if (interactiveQueryService.getCurrentHostInfo().equals(hostInfo)) {

//query from the store that is locally available

}

else {

//query from the remote host

}有关这些主机查找方法的更多信息,请参阅这些方法的 Javadoc。对于这些方法,在启动期间,如果底层 KafkaStreams 对象尚未准备就绪,它们可能会抛出异常。上述重试属性也适用于这些方法。

2.9.1. InteractiveQueryService 提供的其他 API 方法

使用以下 API 方法检索与给定存储和键组合关联的 KeyQueryMetadata 对象。

public <K> KeyQueryMetadata getKeyQueryMetadata(String store, K key, Serializer<K> serializer)使用以下 API 方法检索与给定存储和键组合关联的 KakfaStreams 对象。

public <K> KafkaStreams getKafkaStreams(String store, K key, Serializer<K> serializer)2.10. 健康指示器

健康指示器需要依赖 spring-boot-starter-actuator。对于 Maven,请使用

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-actuator</artifactId>

</dependency>Spring Cloud Stream Kafka Streams Binder 提供了一个健康指示器来检查底层 streams 线程的状态。Spring Cloud Stream 定义了一个属性 management.health.binders.enabled 来启用健康指示器。请参阅 Spring Cloud Stream 文档。

健康指示器为每个流线程的元数据提供以下详细信息

-

线程名称

-

线程状态:

CREATED、RUNNING、PARTITIONS_REVOKED、PARTITIONS_ASSIGNED、PENDING_SHUTDOWN或DEAD -

活动任务:任务 ID 和分区

-

备用任务:任务 ID 和分区

默认情况下,只显示全局状态(UP 或 DOWN)。要显示详细信息,属性 management.endpoint.health.show-details 必须设置为 ALWAYS 或 WHEN_AUTHORIZED。有关健康信息的更多详细信息,请参阅 Spring Boot Actuator 文档。

如果所有已注册的 Kafka 线程都处于 RUNNING 状态,则健康指示器的状态为 UP。 |

由于 Kafka Streams binder 中有三个独立的 binder(KStream、KTable 和 GlobalKTable),它们都将报告健康状态。启用 show-details 时,报告的一些信息可能冗余。

当同一个应用程序中存在多个 Kafka Streams 处理器时,将为所有处理器报告健康检查,并按 Kafka Streams 的应用程序 ID 进行分类。

2.11. 访问 Kafka Streams 指标

Spring Cloud Stream Kafka Streams binder 提供了 Kafka Streams 指标,可以通过 Micrometer MeterRegistry 导出。

对于 Spring Boot 2.2.x 版本,指标支持通过 binder 的自定义 Micrometer 指标实现提供。对于 Spring Boot 2.3.x 版本,Kafka Streams 指标支持通过 Micrometer 本地提供。

通过 Boot actuator 端点访问指标时,请确保将 metrics 添加到属性 management.endpoints.web.exposure.include 中。然后,您可以访问 /acutator/metrics 以获取所有可用指标的列表,然后可以通过相同的 URI(/actuator/metrics/<metric-name>)单独访问这些指标。

2.12. 混合使用高级 DSL 和低级 Processor API

Kafka Streams 提供了两种 API 变体。它有一个更高级的 DSL 样式的 API,您可以链式调用各种操作,这对于许多函数式程序员来说可能很熟悉。Kafka Streams 还提供了低级处理器 API。处理器 API 虽然功能强大,并且能够以更低的级别控制事物,但其本质是命令式的。Spring Cloud Stream 的 Kafka Streams binder 允许您使用高级 DSL 或混合使用 DSL 和处理器 API。混合使用这两种变体为您提供了许多选项来控制应用程序中的各种用例。应用程序可以使用 transform 或 process 方法 API 调用来访问处理器 API。

以下是如何在 Spring Cloud Stream 应用程序中使用 process API 结合 DSL 和处理器 API 的示例。

@Bean

public Consumer<KStream<Object, String>> process() {

return input ->

input.process(() -> new Processor<Object, String>() {

@Override

@SuppressWarnings("unchecked")

public void init(ProcessorContext context) {

this.context = context;

}

@Override

public void process(Object key, String value) {

//business logic

}

@Override

public void close() {

});

}以下是使用 transform API 的示例。

@Bean

public Consumer<KStream<Object, String>> process() {

return (input, a) ->

input.transform(() -> new Transformer<Object, String, KeyValue<Object, String>>() {

@Override

public void init(ProcessorContext context) {

}

@Override

public void close() {

}

@Override

public KeyValue<Object, String> transform(Object key, String value) {

// business logic - return transformed KStream;

}

});

}process API 方法调用是终端操作,而 transform API 是非终端操作,它为您提供一个潜在转换的 KStream,您可以使用它继续使用 DSL 或处理器 API 进行进一步处理。

2.13. 出站分区支持

Kafka Streams 处理器通常将处理后的输出发送到出站 Kafka 主题。如果出站主题已分区并且处理器需要将出站数据发送到特定分区,则应用程序需要提供一个 StreamPartitioner 类型的 bean。有关详细信息,请参阅 StreamPartitioner。让我们看一些示例。

这与我们之前多次看到的处理器相同,

@Bean

public Function<KStream<Object, String>, KStream<?, WordCount>> process() {

...

}这是输出绑定目的地

spring.cloud.stream.bindings.process-out-0.destination: outputTopic如果主题 outputTopic 有 4 个分区,如果您不提供分区策略,Kafka Streams 将使用默认分区策略,这可能不是您想要的输出,具体取决于特定用例。假设您想将任何匹配 spring 的键发送到分区 0,将 cloud 发送到分区 1,将 stream 发送到分区 2,将所有其他键发送到分区 3。以下是您需要在应用程序中执行的操作。

@Bean

public StreamPartitioner<String, WordCount> streamPartitioner() {

return (t, k, v, n) -> {

if (k.equals("spring")) {

return 0;

}

else if (k.equals("cloud")) {

return 1;

}

else if (k.equals("stream")) {

return 2;

}

else {

return 3;

}

};

}这是一个粗略的实现,但是,您可以访问记录的键/值、主题名称和分区总数。因此,如有需要,您可以实现复杂的分区策略。

您还需要将此 bean 名称与应用程序配置一起提供。

spring.cloud.stream.kafka.streams.bindings.process-out-0.producer.streamPartitionerBeanName: streamPartitioner应用程序中的每个输出主题都需要像这样单独配置。

2.14. StreamsBuilderFactoryBean 定制器

通常需要自定义创建 KafkaStreams 对象的 StreamsBuilderFactoryBean。基于 Spring Kafka 提供的底层支持,binder 允许您自定义 StreamsBuilderFactoryBean。您可以使用 StreamsBuilderFactoryBeanCustomizer 来自定义 StreamsBuilderFactoryBean 本身。然后,一旦您通过此定制器访问 StreamsBuilderFactoryBean,您就可以使用 KafkaStreamsCustomzier 自定义相应的 KafkaStreams。这两个定制器都是 Spring for Apache Kafka 项目的一部分。

以下是使用 StreamsBuilderFactoryBeanCustomizer 的示例。

@Bean

public StreamsBuilderFactoryBeanCustomizer streamsBuilderFactoryBeanCustomizer() {

return sfb -> sfb.setStateListener((newState, oldState) -> {

//Do some action here!

});

}上面所示的只是一个示例,说明了您可以如何自定义 StreamsBuilderFactoryBean。您可以调用 StreamsBuilderFactoryBean 中的任何可用修改操作来自定义它。此定制器将在工厂 bean 启动之前由 binder 调用。

一旦您获得了 StreamsBuilderFactoryBean 的访问权限,您还可以自定义底层的 KafkaStreams 对象。以下是实现此目的的蓝图。

@Bean

public StreamsBuilderFactoryBeanCustomizer streamsBuilderFactoryBeanCustomizer() {

return factoryBean -> {

factoryBean.setKafkaStreamsCustomizer(new KafkaStreamsCustomizer() {

@Override

public void customize(KafkaStreams kafkaStreams) {

kafkaStreams.setUncaughtExceptionHandler((t, e) -> {

});

}

});

};

}KafkaStreamsCustomizer 将在底层 KafkaStreams 启动之前由 StreamsBuilderFactoryBeabn 调用。

整个应用程序中只能有一个 StreamsBuilderFactoryBeanCustomizer。那么,我们如何处理多个 Kafka Streams 处理器呢,因为它们每个都由独立的 StreamsBuilderFactoryBean 对象支持?在这种情况下,如果这些处理器的自定义需要不同,那么应用程序需要根据应用程序 ID 应用一些过滤器。

例如,

@Bean

public StreamsBuilderFactoryBeanCustomizer streamsBuilderFactoryBeanCustomizer() {

return factoryBean -> {

if (factoryBean.getStreamsConfiguration().getProperty(StreamsConfig.APPLICATION_ID_CONFIG)

.equals("processor1-application-id")) {

factoryBean.setKafkaStreamsCustomizer(new KafkaStreamsCustomizer() {

@Override

public void customize(KafkaStreams kafkaStreams) {

kafkaStreams.setUncaughtExceptionHandler((t, e) -> {

});